Emulación de SSD en Proxmox: qué cambia realmente y cómo aprovechar TRIM y el I/O en tus VMs

En muchas infraestructuras virtualizadas, la sensación de “lentitud” en una máquina virtual no siempre viene de una falta de CPU o RAM, sino de cómo se están gestionando los accesos a disco. En Proxmox VE, uno de los ajustes más malinterpretados —y a la vez más útiles cuando se aplica con criterio— es la emulación de SSD: […]

Análisis del PNY CS3250 M.2 1TB

PNY Technologies, conocida como fabricante de tarjetas gráficas, se ha propuesto desarrollar el SSD más rápido y está lanzando un nuevo SSD NVMe: el PNY CS3250 M.2. Se dice que el SSD PCIe Gen 5 x4 alcanza velocidades de lectura secuenciales de hasta 14.900 MB/s y velocidades de escritura de hasta 14.000 MB/s. Con un […]

Precios de almacenamiento evaluados en 2025: Parece malo, pero también hay motivos para la esperanza

El año 2025 ha ofrecido mucho, pero también una extraordinaria explosión de precios para la memoria tanto para jugadores como para montadores de PC. ¿Cuál es el estado real de los kits, discos duros y SSD de RAM a finales de año? ¿Hay alguna razón para la esperanza en las cifras? Una evaluación. ¿¿Qué pasó? […]

Discos duros: La IA dispara el precio de los discos duros un 46%

Tras meses de aumentos en los precios de las tarjetas gráficas y de memorias RAM, la Inteligencia Artificial ha encontrado en los discos duros una nueva víctima. Discos duros: La IA dispara el precio de los discos Según un informe reciente de ComputerBase, el precio medio de los discos duros de alta capacidad ha subido un 46% desde septiembre, […]

SSD: Fabricantes priorizan el mercado de memorias DRAM y podría haber escasez de unidades de almacenamiento

SSD: Podría haber aumentos de precios por recortes de producción Según informes recientes de Chosun Biz, gigantes de la industria como Samsung y SK hynix están planeando recortar su producción de memoria NAND Flash, la tecnología base de los SSD, con el objetivo de maximizar sus márgenes de beneficio. El motivo principal de este movimiento es la alta rentabilidad que […]

Kioxia advierte que los SSD de 1TB por debajo de 50 dólares son cosa del pasado

La demanda de IA mantendrá altos los precios de la memoria hasta 2027 Facepalm: Kioxia, una empresa escindida de Toshiba en 2018 y a la que se le atribuye la invención de la memoria flash, predice que el mercado de la memoria estará influenciado por inversiones relacionadas con la IA durante al menos los próximos dos […]

PNY: Usuarios reportan cierres causados por adhesivos en los pines PCIe

PNY: Reportan problemas por adhesivos en los pines PCIe Un usuario comenzó a experimentar cierres inesperados y un rendimiento errático en su ordenador tras instalar una nueva tarjeta gráfica de la marca PNY. Lo que inicialmente parecía un defecto de fábrica o un problema de compatibilidad, resultó ser un algo más impensado. Al desmontar la tarjeta […]

SanDisk duplicará el precio de sus SSD empresariales en 2026

Según informes recientes de analistas de Nomura Securities, SanDisk se prepara para duplicar el precio de sus módulos de memoria 3D NAND de alta capacidad para las unidades SSD de nivel empresarial durante el primer trimestre. SanDisk duplicará el precio de sus SSD empresariales Esta decisión no es un hecho aislado, sino una respuesta directa a la insaciable […]

Los SSD M.2 con menos TBW que no recomendamos comprar, ¡hay mejores opciones!

Recopilamos los SSD M.2 con menos TBW para decirte qué no debes comprar, ¡te damos alternativas en el post! Hablemos de TeraBytes escritos, una magnitud conocida como TBW que prácticamente todo el mundo la conoce ya. A la hora de comprar un SSD, te debes fijar en varias cosas: qué memorias NAND Flash lleva, qué TBW […]

SanDisk presenta Optimus, sus nuevos SSD que jubilan a los WD Black y Blue

SanDisk ha anunciado en el CES la jubilación definitiva de la icónica nomenclatura basada en colores de Western Digital (WD Black y WD Blue), dando paso a la nueva familia SanDisk Optimus. SanDisk Optimus: Nueva marca que jubila los SSD WD Black/Blue Las conocidas líneas WD Black y WD Blue desaparecerán de las estanterías para dar paso a la renacida familia SanDisk Optimus, una […]

Samsung subió los precios de los chips de memoria hasta un 60% desde septiembre, según informes: la construcción de centros de datos de IA estrangula el suministro

Esto podría ser el canario en la mina de carbón para precios de memoria mucho más altos en el futuro. Es probable que los precios de los productos electrónicos que usan memoria flash NAND sigan subiendo, ya que Samsung ha incrementado los precios de sus chips de memoria individuales hasta en un 60% desde septiembre, […]

El CEO de Phison confirma que los precios de la NAND se han más que duplicado y seguirán subiendo, ya que toda la producción de 2026 se agotó — los SSD enfrentan un apocalipsis de precios durante todo 2027

La oferta seguirá siendo deficiente durante algunos años. Mientras se desarrolla una crisis sin precedentes de DRAM, la inteligencia artificial está sembrando el caos en otro frente: el almacenamiento. Los centros de datos que utilizan discos duros casi de línea están cambiando a SSD para evitar los plazos de entrega, lo que ha provocado una […]

Cómo desbloquear el nuevo driver NVMe de Windows 11 para aumentar el rendimiento de tu SSD

Hace poco nos enteramos de que Windows ha estado tratando a tu moderno y ultrarrápido SSD NVMe como si fuera un dispositivo mucho más antiguo. Durante años, el sistema operativo ha utilizado una capa de traducción para convertir los comandos NVMe al viejo protocolo SCSI. Es funcional, sí, pero es como tener un superdeportivo y […]

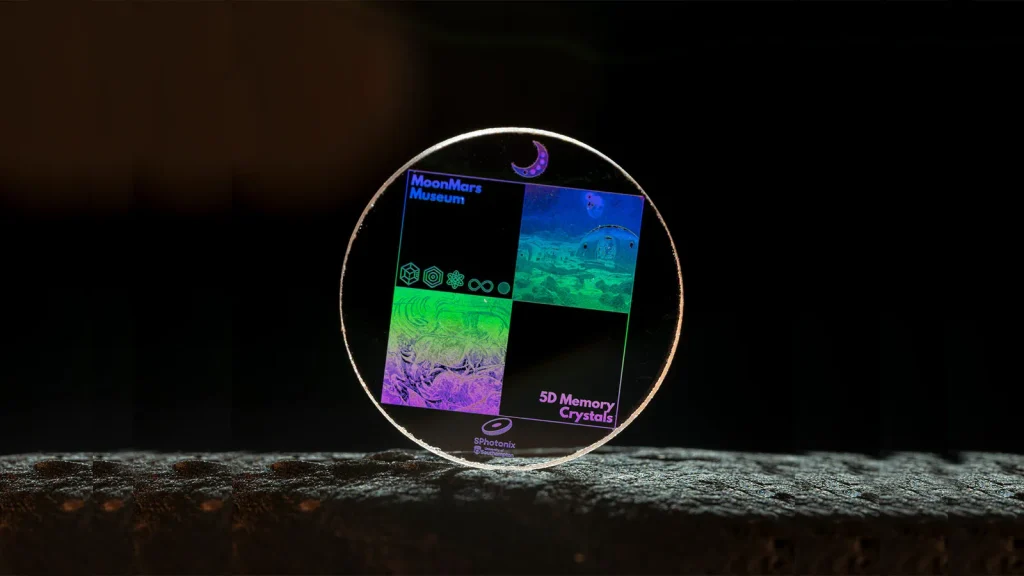

Almacenamiento 5D en vidrio, ¿la futura solución a la crisis de los SSD?

Los HDD y SSD, al igual que las unidades ópticas e incluso las tradicionales de cinta, son perfectas para almacenar grandes cantidades de datos, sin embargo, no por mucho tiempo, ya que, con el paso de los años y su uso se va desgradando hasta perder la información o dejarla inaccesible. Para evitar este tipo […]

Los precios de la memoria RAM se triplican en solo 3 meses y les acompaña una subida de un 42% en los SSD y un 33% en los HDD para completar el año

Si te has esperado hasta estas Navidades y Reyes para comprarte un nuevo ordenador o actualizarte el tuyo, tenemos muy malas noticias para ti. Los precios de los componentes son mucho más altos de lo que deberían en estas épocas del año y si has estado leyendo noticias e informes, ya sabrás el porqué. Uno […]

Biwin crea el SSD definitivo: tan pequeño como una microSD y con hasta 2 TB

Si bien es cierto que las unidades de almacenamiento M.2 en sus diferentes formatos son prefectas para la mayoría de los equipos por su reducido tamaño, no son la mejor opción en el cada vez más amplio mercado de consolas portátiles que obliga a los fabricantes a crear sobre esta y permitiendo que se pueda reemplazar con […]

Olvida todo lo que conoces sobre los SSD: Samsung prepara uno de 512 TB

Las soluciones de almacenamiento ofrecen una serie de aspectos únicos que diferencian los modelos empresariales de los personales. Y esta vez Samsung ha dejado claro que quieren crear las versiones orientadas para profesionales con las mejores capacidades posibles, ya que han anunciado que están desarrollando un SSD que ofrecerá medio Petabyte, es decir, 512 TB. Desde hace muchos años Samsung […]

Samsung muestra el primer SSD modular del mercado (y un M.2 con DRAM)

Faltan casi dos meses para el CES 2026, la feria de informática y tecnología más importante del año junto con el Computex, y eso significa que los fabricantes ya han puesto su maquinaria a trabajar y muchos de ellos están dando ya adelantos de lo que presentarán. Es el caso de Samsung, quien entre otras muchas cosas […]

Samsung niega los rumores sobre su salida del mercado de los SSD para consumidores

La salida de Micron del mercado orientado para consumidores ha dejado huella. Es por ello que muchos usuarios han comenzando a especular sobre qué pasaría si otras compañías líderes del sector hiciesen lo mismo. Pero uno de los rumores que indicaba cómo la compañía surcoreana líder en memoria podría seguir el mismo camino ha sido desmentido por […]

Tu PC, portátil o consola pedían un SSD así: llega el Kioxia EXCERIA G3

En el mercado podemos encontrar un gran número de fabricantes de unidades de almacenamiento, con soporte para PCIe 4.0 y PCIe 5.0 en una amplia gama de precios. Kioxia, que se ha convertido en uno de los favoritos de muchos usuarios por su excelente relación calidad precio, acaba de ampliar su gama de productos para consumidores con el EXCERIA G3. […]

El almacenamiento de tu PC vuelve a estar en jaque: la escasez llega a los HDD

Últimamente resulta sencillo ver cómo han subido los precios a la hora de montar un PC. No solo en los modelos de gama alta, sino también en aquellos que aprovechan piezas más antiguas para lograr un propósito más básico. Y si no era suficiente ver cómo las unidades de almacenamiento SSD aumentaban sus precios por la falta […]

Crucial abandona el mercado doméstico de la RAM y SSD para centrarse en la IA

La crisis de la memoria RAM no ha hecho más que comenzar. En los últimos meses, su precio no solo duplicado o incluso triplicado haciendo que, en la actualidad, solo la memoria RAM cuesta más de una PS5. La falta de stock de la memoria RAM, no solo está afectando a su precio, sino también a […]

SSD 512 GB vs 1 TB vs 2 TB ¿Cuánto almacenamiento necesito en mi PC?

Cuando vas a comprar una nueva unidad de almacenamiento, ya sea SSD, HDD, interna o externa, siempre surge la duda sobre la capacidad que necesitas. Esto varía mucho según cada caso, y el precio de una capacidad a otra puede significar una enorme diferencia, pero tampoco es menos importante el hecho de comprar una unidad que […]

Como sé que un SSD se muere

Las unidades SSD han demostrado ser incluso más fiables que los HDD, pese a las serias dudas que existía en un inicio cuando aparecieron las memorias de estado sólido. Ahora que ya casi todos usan SSDs, toca velar por tus datos y prevenir posibles problemas y pérdida de datos, ya que pese a su fiabilidad, eso no […]

Estos son los SSD con más TBW que puedes comprar para la mayor vida útil

El TBW es la magnitud usada para medir la cantidad de TeraBytes que podremos escribir en un SSD antes de que empiecen a salir los fallos. Sí, varía en función de la capacidad total de la unidad, por lo que las unidades con más TB, tendrán más TBW que aquellas de menor capacidad. Aquí no […]

El NVMe Destroyinator es el destructor de datos más rápido del mercado: puede borrar hasta 16 discos NVMe a velocidades de hasta 64 GB/s

El NVMe Destroyinator es un dispositivo ideal para empresas con datos sensibles Hablar de manera positiva del borrado de datos no parece algo demasiado lógico. No obstante, hay empresas que deben borrar datos de manera continuada debido a su modelo de negocio. Para estos casos, el anuncio de 45Drives viene como caído del cielo. El dispositivo que […]

Adiós a la memoria RAM y al SSD: esta tecnología lo cambia todo y ya es real

Durante décadas, la informática ha vivivo «atrapada» en una dualidad: la memoria RAM es rápida pero volátil, y la memoria NAND es persistente, pero con fecha de caducidad y bastante más lenta que la RAM. Ahora, un nuevo avance científico e industrial promete derribar esta barrera: se trata de la UltraRAM, una tecnología que combina la […]

¿Tu PC va lento? Tu SSD podría ser el culpable y así puedes comprobarlo

Cuando te compras un nuevo PC o cuando estrenas un nuevo SSD, el equipo siempre va volando. Sin embargo, con el tiempo puedes empezar a notar que su rendimiento o desempeño ya no es el que era o incluso que te da problemas, y llegado ese momento deberías preguntarte si va todo bien. En este artículo te contamos cómo […]

La influencia del firmware en el rendimiento de SSDs

Si queremos que nuestro ordenador funcione como el primer día, no solo debemos preocuparnos de instalar todas las actualizaciones del sistema operativo y limpiar su interior periódicamente. Además, también debemos comprobar, periódicamente, si alguno de los componentes de nuestro PC tiene una nueva actualización del firmware. Cuando hablamos del firmware de un dispositivo, hablamos del […]

Qué es la vida útil de un SSD y cómo saber si está fallando

Una de las partes más importantes de cualquier PC, quizás la más importantes de todas, es la unidad de almacenamiento. La unidad de almacenamiento en la que se encarga de almacenar el sistema operativo y de guardar todos los archivos que creemos o copiemos. ndice Si la unidad de almacenamiento deja de funcionar, ya sea […]

El misterio de los SSD que fallan en Windows se resuelve: Phison era el culpable

En las últimas semanas hemos vivido uno de esos culebrones en la industria del hardware que terminan alargándose cual sombra al atardecer, pero que en esta ocasión han llegado pronto a una conclusión clara y final. Resulta que, tras una actualización de Windows 11, varios modelos de SSD con controladora Phison comenzaron a fallar, desapareciendo del sistema como […]

Samsung ya tiene su hoja de ruta para el CES 2026: memoria LPDDR6 y SSD de nueva generación

Samsung ya prepara su presencia en el CES 2026, donde mostrará algunos de los avances más importantes de su catálogo de memoria y almacenamiento. LPDDR6: más velocidad y eficiencia para una nueva generación de dispositivos El CES 2026 se celebrará en apenas un par de meses, y Samsung ya tiene claro con qué tratará de sorprender. […]

Cómo clonar tu disco a NVMe sin reinstalar Windows (paso a paso seguro)

Dar el salto a una unidad NVMe es una de esas mejoras que se notan desde el primer arranque: más velocidad, menos latencia y un sistema que responde al instante. Si ya tienes tu PC funcionando, lo lógico es querer migrarlo tal cual sin reinstalar Windows ni tus aplicaciones. La buena noticia es que puedes clonar tu […]

SSD NVMe a 70 °C sin jugar: causas, diagnóstico y soluciones efectivas

¿Qué hacer cuando la temperatura de tu SSD NVMe sube de 70 °C? Si tu SSD NVMe marca 70–72 °C sin estar jugando, no eres el único. En muchos equipos, el módulo M.2 queda muy cerca de la gráfica y recibe su calor residual incluso cuando no estás en plena carga, lo que puede elevar la temperatura de […]

JEDEC UFS 5.0: el salto a 10,8 GB/s en almacenamiento móvil

La organización JEDEC ha presentado oficialmente el nuevo estándar UFS 5.0, diseñado para ofrecer velocidades de transferencia secuenciales de hasta 10,8 GB/s. JEDEC UFS 5.0: el nuevo estándar que alcanza hasta 10,8 GB/s Este salto representa una mejora significativa respecto a la generación anterior y marca un paso clave en el desarrollo del almacenamiento de alto rendimiento para dispositivos […]

Esta configuración de Windows 11 (que seguramente tienes activa) está restando años de vida a tu disco SSD

Dejar Windows 11 con la configuración por defecto es perjudicial para el disco duro. El SSD está en constante peligro si usas inadecuadamente la memoria virtual. No hay que saber mucho de ordenadores para entender que el disco duro es uno de los componentes más importantes, pues aquí es donde se almacenan todas las aplicaciones, archivos […]

Memoria y almacenamiento, al límite: la ola de IA vacía el “granero” de DRAM, NAND, SSD y HDD y dispara los precios

La industria de la memoria vive una situación inédita: DRAM, NAND Flash, SSD y discos duros se han quedado simultáneamente en mínimos. Lo que durante meses se temió como un ciclo alcista sostenido ha desembocado en escasez generalizada que ya se nota en contratos y precios de contado, y que amenaza con trasladarse a lineales y presupuestos de hogares y […]

Análisis KINGSTON XS1000, un SSD de hasta 2 TB minúsculo pero gigante en prestaciones

Hemos tenido la oportunidad de probar una de las unidades de almacenamiento SSD más sorprendentes del mercado. Kingston ha logrado con su XS1000 una miniaturización extrema de un SSD que, en el tamaño de un mechero, nos permite llevar en el bolsillo de las monedas del pantalón vaquero hasta 2TB de información. Indice: Unboxing y diseño Es […]

512 TB en un solo SSD: Samsung destroza la lógica y te deja sin excusas para borrar nada en 2027

Si creías que guardar fotos, vídeos y archivos pesados era ya un problema resuelto, espera a ver lo que Samsung tiene preparado para 2027. 512 TB en un solo SSD. La compañía surcoreana quiere cambiar por completo el mundo del almacenamiento con un plan bastante arriesgado y ambicioso que quiere, por fin, dar un salto […]

Discos duros, de los Megabytes a la era Terabyte y más allá

La trayectoria de los discos duros (HDD) es de más de 60 años y en ella hemos podido ver la transformación desde voluminosos dispositivos de baja capacidad a soluciones de alta densidad a un coste efectivo. Los primeros HDD, surgidos en la década de 1950, tenían el tamaño de un armario, pesaban casi una tonelada […]

¿Desaparecerán los HDD pronto? ¿Solo usaremos SSD?

Los HDD nos han acompañado desde hace décadas, y por el momento siguen, incluso tras la aparición de los SSD y su superioridad técnica. Otros medios han desparecido, han quedado obsoletos, como los disquetes o algunos medios ópticos, casetes, etc., ¿le pasará lo mismo a los HDD o aún tienen mucho recorrido por delante? Actualidad En 2025 […]

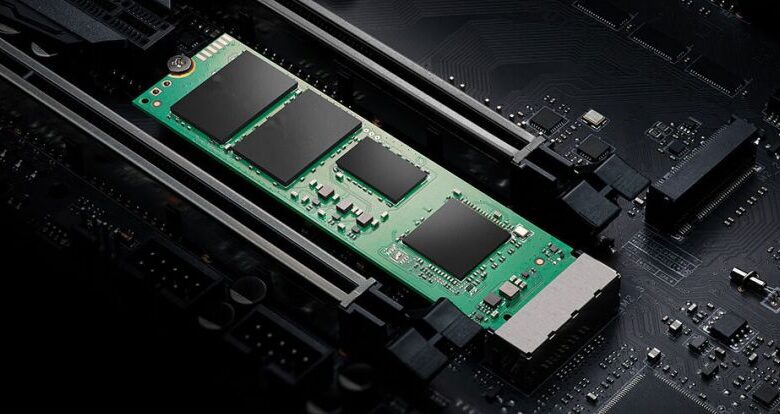

SSD NVMe Gen5 vs Gen4 ¿Compensa la diferencia económica?

La batalla entre los SSD NVMe Gen5 y Gen4 está en pleno auge, y no es solo una cuestión de números: es una evolución que redefine el rendimiento, la eficiencia y el futuro del almacenamiento en PC. Pero… ¿realmente un usuario siente esa mejoría en la experiencia? En este artículo exploraremos las diferencias clave entre ambas generaciones, […]

Hacer particiones a un SSD, ¿afecta a su rendimiento?

Muchos son los fabricantes de portátil que venden sus equipos con una copia de respaldo del sistema operativo para recuperar en caso de que el equipo no funcione como el primer día. Esta copia de respaldo permite recuperar el equipo a su estado de fábrica sin tener que instalar Windows de cero y no se encuentra en […]

Cómo saber cuántas horas de uso tiene tu disco duro o SSD

El disco duro o SSD es uno de los componentes más importantes de cualquier PC, ya que es el que se utiliza para encender el ordenador y, sobre todo, almacenar toda la información. Si el disco duro o SSD deja de funcionar, y no hemos tenido la precaución de hacer una copia de seguridad periódica o utilizar una plataforma […]

Windows 11 vuelve a fallar: la última actualización da problemas con algunos SSD

Las actualizaciones de Windows 11 siguen dándole quebraderos de cabeza tanto a usuarios como fabricantes. En esta ocasión, el problema es bastante grave ya que la actualización KB5063878 incluida en la versión 24H2, build 26100.4946 está provocando fallos críticos en unidades SSD con controladora Phison. En seguida te contamos cuál es el problema y cómo saber si tu SSD estaría afectado, pero […]

¿Cómo afecta la temperatura de los SSD a su rendimiento?

Es difícil creer que solo ha pasado un año desde que presenciamos por primera vez la radical tecnología de enfriamiento AirJet Mini de estado sólido de Frore System en CES 2023. Prometiendo una revolución en el rendimiento de enfriamiento de las computadoras portátiles, desde entonces ha llegado a las tiendas a través de la mini PC Zotac […]

Crucial vs SanDisk, ¿Qué marca de memorias es mejor?

En el almacenamiento de datos, dos nombres destacan por su presencia en el mercado, en este caso me estoy refiriendo a Crucial y SanDisk. Ambas marcas han construido una sólida reputación ofreciendo soluciones que van desde tarjetas SD hasta discos SSD, pero ¿cuál de las dos tiene las mejores memorias? En este artículo desgranaremos toda la […]

Almacenamiento híbrido: ¿merece la pena combinar SSD y HDD aún?

El almacenamiento sigue siendo uno de los factores determinantes dentro de la experiencia de un PC, tanto si está dedicado a jugar como a cualquier otra tarea. Contar con una buena cantidad de gigabytes disponibles es algo imprescindible, y aunque lo más recomendado es apostar por uno o varios SSD, todavía hay mucha gente que […]

Por qué dos SSD son mejores que uno en su PC

El ancho de banda de la competencia ralentizará las cosas, seguro. Si está buscando acelerar su PC, debería considerar usar dos SSD en lugar de uno. Una forma de hacerlo es configurar las dos unidades en una matriz RAID 0. Esto permite combinar las velocidades de lectura y escritura de ambos SSD, lo que da como resultado […]

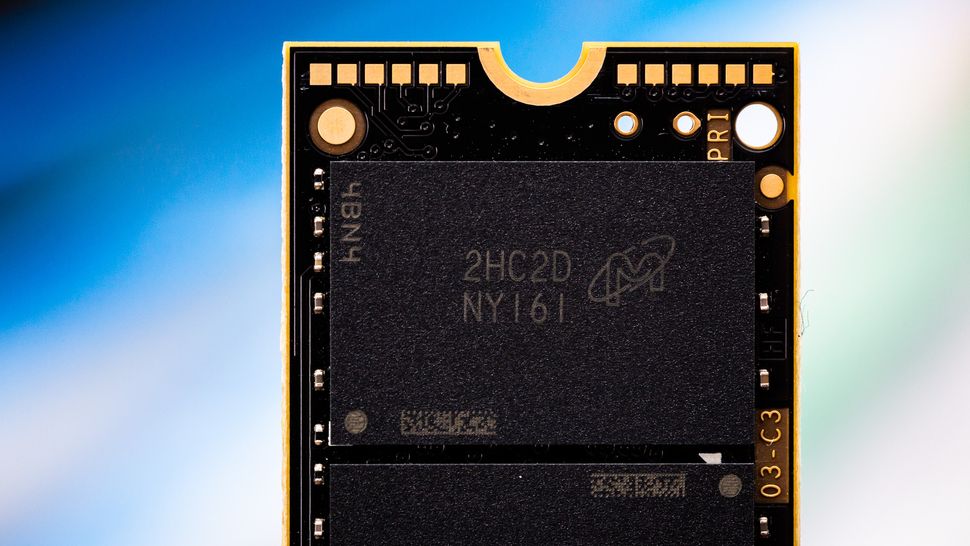

Micron presenta su nuevo SSD NVMe 2600 con escritura adaptativa: más rápido y eficiente que nunca

La compañía ha anunciado el Micron 2600 SSD NVMe, un modelo que destaca por encima de todo por su nueva tecnología de escritura adaptativa (AWT) y por ser el primer modelo con memoria QLC de 9.ª generación Micron 2600 SSD NVMe: QLC de última generación y velocidades de récord El Micron 2600 destaca por ser el primer SSD del mercado […]

PCIe Gen 6: el primer controlador admite velocidades de hasta 28 GB/s

Silicon Motion presenta de su primer controlador SSD PCIe Gen 6 para empresas, el SM8466. Este componente, diseñado para los centros de datos más exigentes, promete duplicar las velocidades de la generación actual, alcanzando hasta 28 GB/s, y ofrecer capacidades masivas de hasta 512 TB. PCIe Gen 6: Presentan el controlador SM8466 Perteneciente a la serie MonTitan, […]

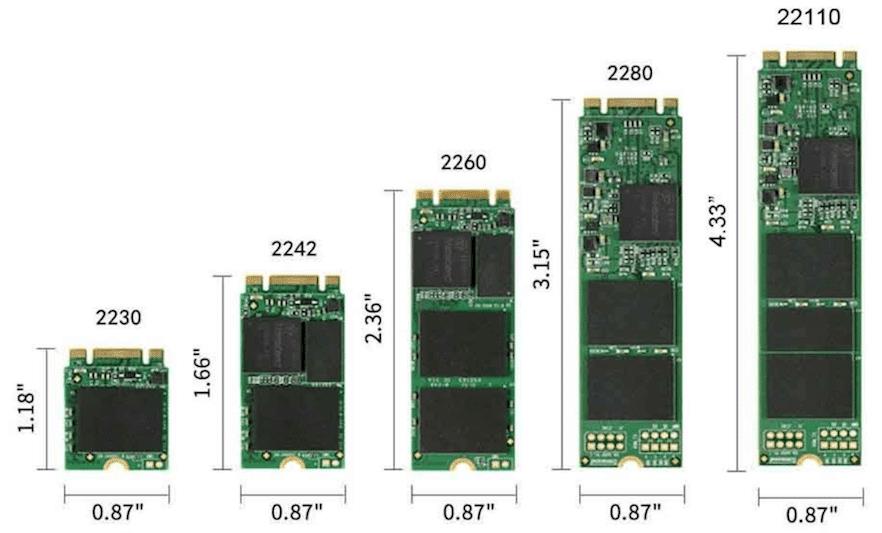

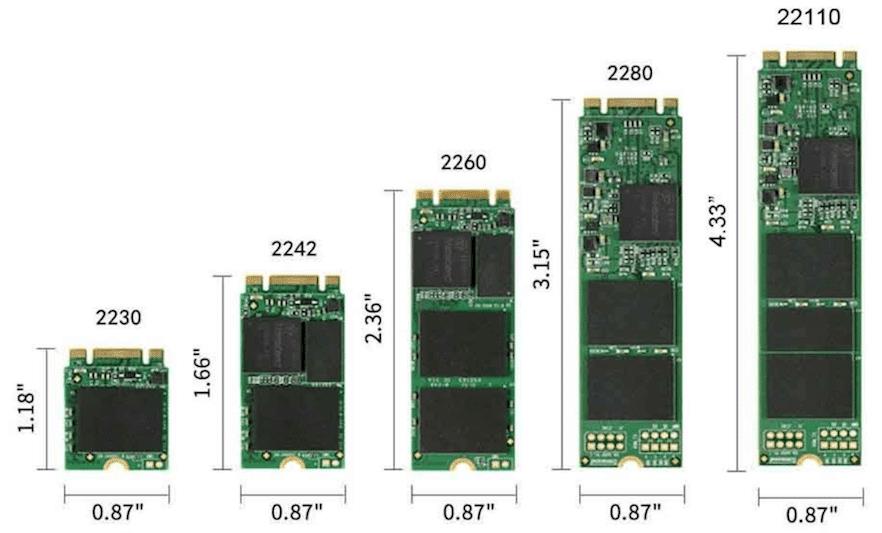

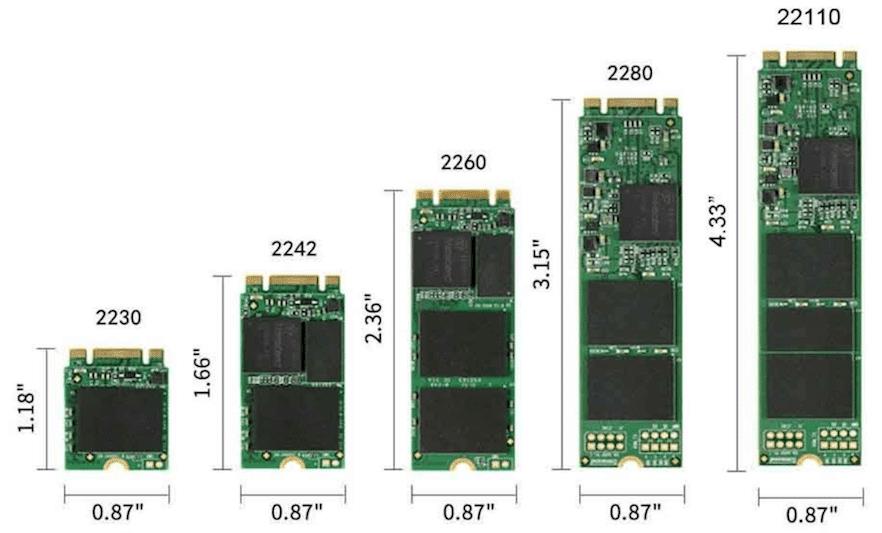

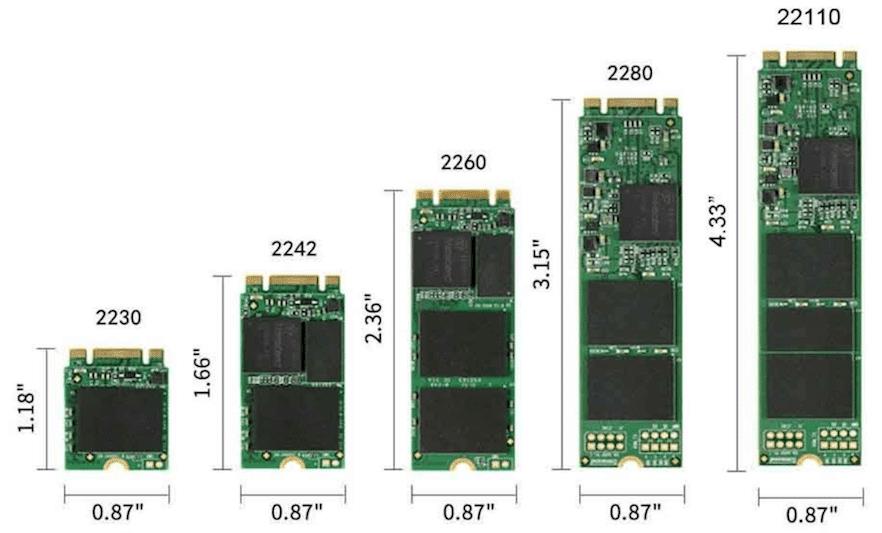

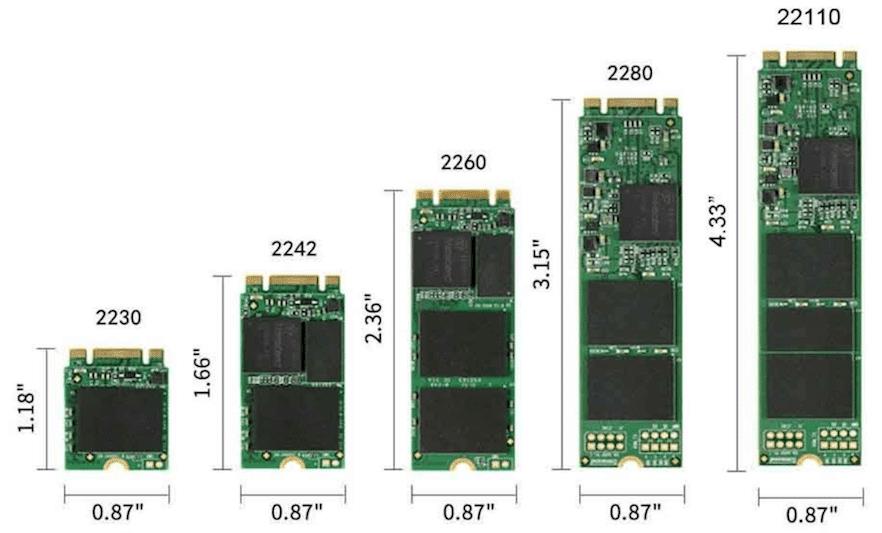

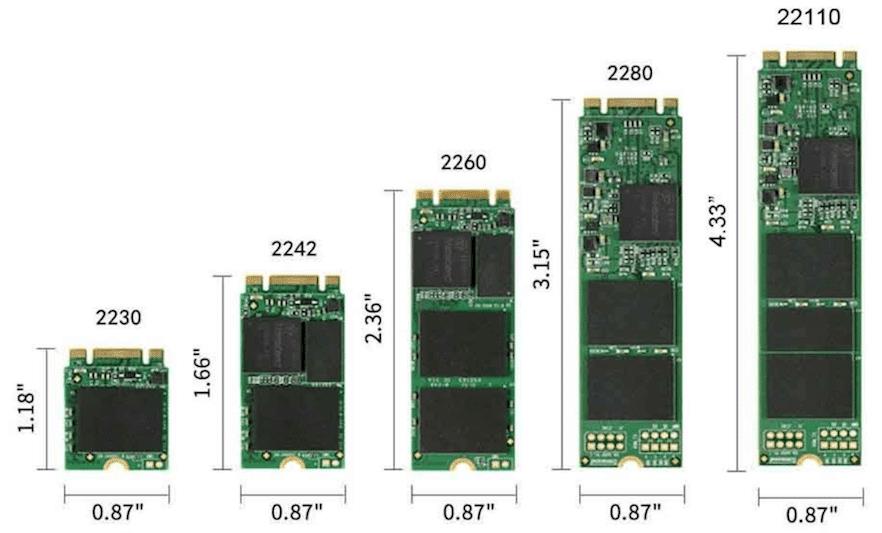

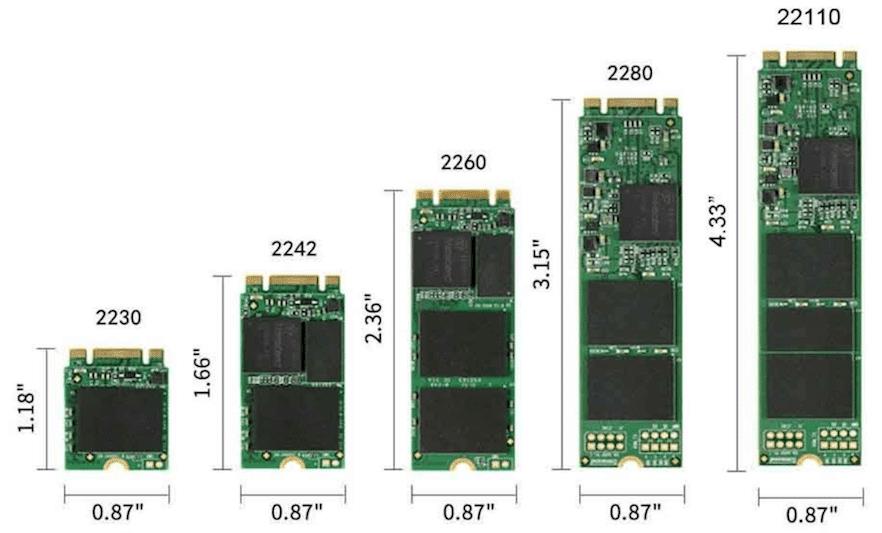

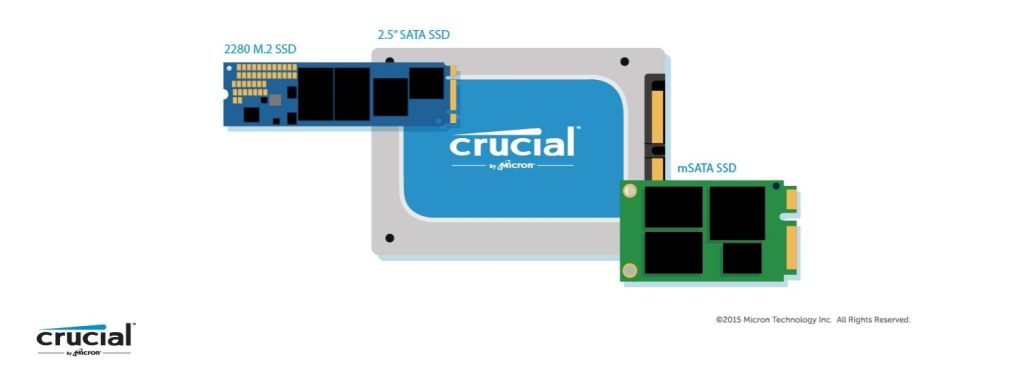

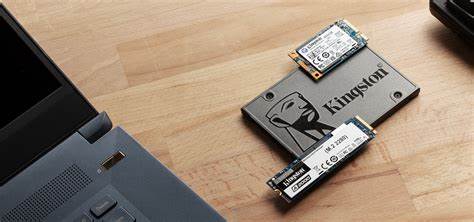

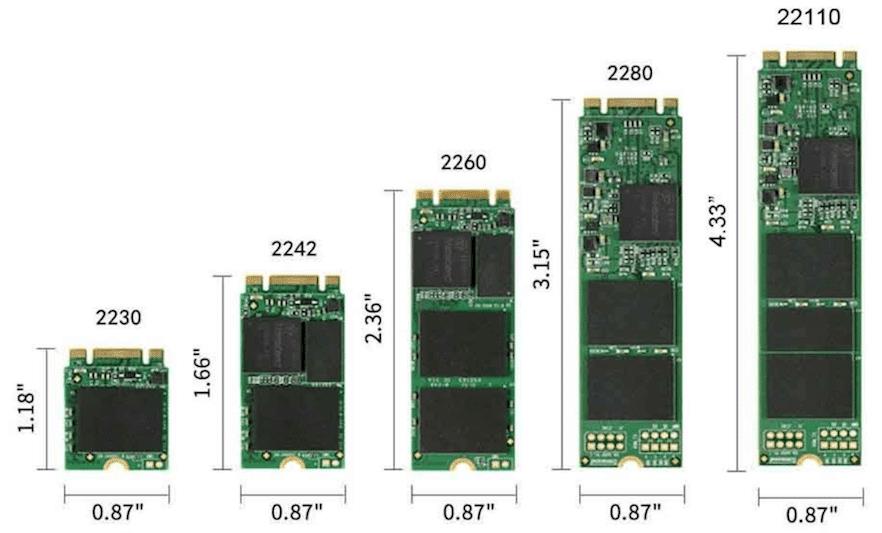

¿Cuál es la diferencia entre una ranura M.2 2230 y 2242?

Las ranuras M.2 son una especificación de interfaz compacta para conectar módulos, particularmente unidades de estado sólido (SSD), a través de PCIe. Los identificadores numéricos de las ranuras M.2, como 2230 y 2242, denotan sus dimensiones físicas, que son cruciales para la compatibilidad con las SSD M.2. La principal distinción entre las ranuras M.2 2230 […]

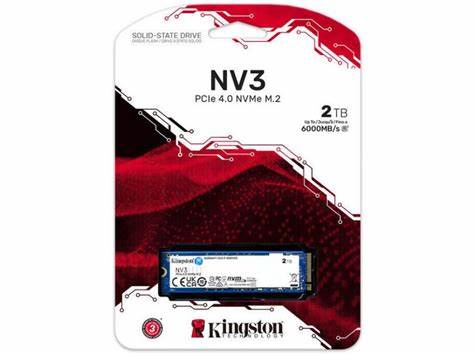

Kingston lanza sus SSD NV3 en formato M.2 2230 para portátiles y consolas

Kingston ha anunciado oficialmente la expansión de su popular serie de SSD NV3 al compacto factor de forma M.2 2230. Kingston Lanza sus SSD NV3 en formato M.2 2230 Este nuevo formato está abriendo nuevas posibilidades de actualización para una creciente gama de dispositivos. Diseñadas específicamente para portátiles delgados y consolas de videojuegos portátiles como Steam Deck o el ASUS ROG […]

La SSD Micron 2600 QLC utiliza un almacenamiento en caché flexible para ofrecer un rendimiento similar al de TLC: 7.200 MB/s de lectura y 6.500 MB/s de escritura superan los límites de PCIe 4.0

El SSD está diseñado para fabricantes de equipos originales Micron presenta su nuevo SSD NVMe 2600 con escritura adaptativa: más rápido y eficiente que nunca Micron ha presentado un nuevo SSD de cliente diseñado para OEM que compite con los mejores SSD del mercado minorista. El Micron 2600 está disponible en tres factores de forma distintivos, proporcionando […]

Mito o realidad: ¿se puede destruir un disco duro utilizando un imán?

Seguramente habréis escuchado alguna vez que los discos duros o HDD tradicionales pueden ser extremadamente resistentes frente a la mayoría de daños que puede sufrir un componente de PC, incluso después de un golpe realmente fuerte puede que continúen funcionando, pero hay algo que puede destruir uno solo con ponerlo encima, un imán. Los discos duros utilizan una serie de elementos […]

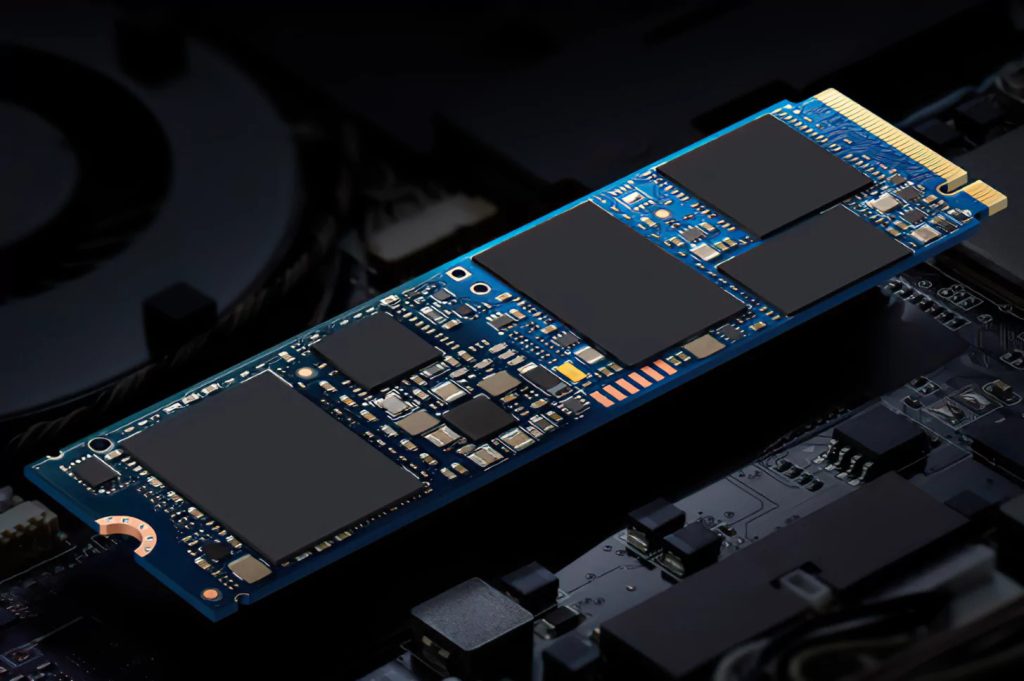

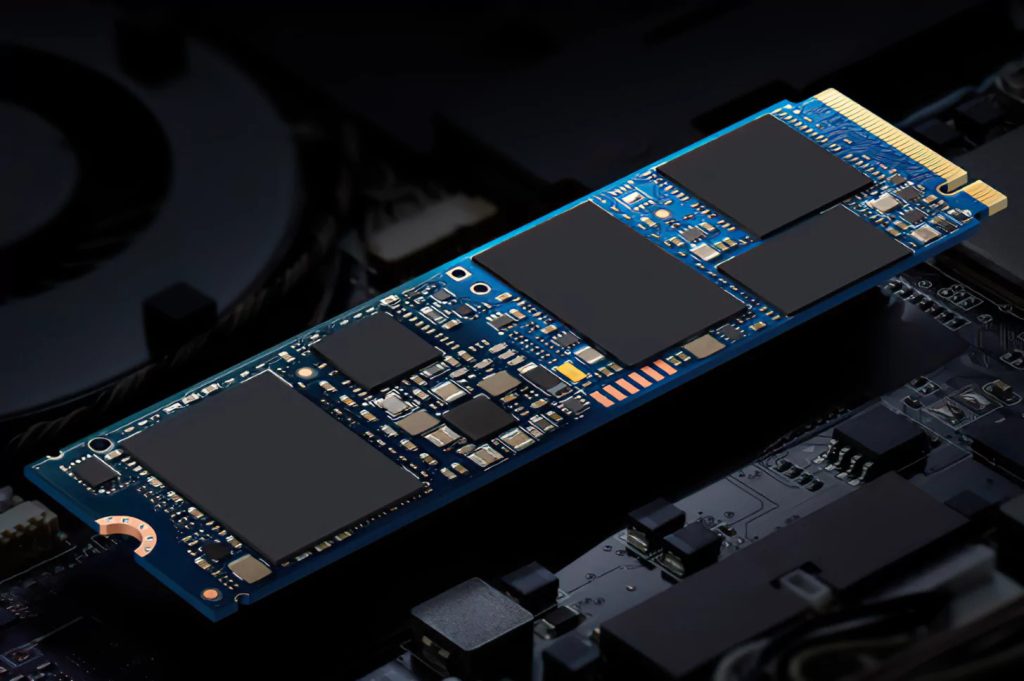

Esta es la diferencia más grande entre los SSD M.2

Los componentes que tiene un PC pueden ser muy diferentes pese a que cumplen la misma función, como bien sabréis existen modelos de dispositivos de almacenamiento que logran ofrecer una velocidad más alta que los HDD y los SSD tradicionales, pero incluso estos tienen alguna que otra diferencia entre sí y es por ello que os vamos a comentar la más […]

Los SSD PCIe 5.0 dominarán el mercado hasta 2030, ¿por qué PCIe 6.0 está todavía tan lejos?

A finales de 2024, muchos son los fabricantes de unidades de almacenamiento SSD que empezaron a abandonar las líneas de producción de unidades SSD PCIe 3.0 para centrar su actividad en unidades PCIe 4.o y PCIe 5.0 un movimiento que podría dar a entender que las unidades PCIe 6.0 estarían a la vuelta de la esquina, sin embargo, no es […]

SSD PCIe 5.0: Las unidades se mantendrán durante los próximos cinco años

Las unidades SSD PCIe 5.0 seguirán siendo la norma en el mercado de consumo durante los próximos cinco años, ya que el estándar PCIe 6.0 no se espera antes de 2030, según declaraciones del CEO de Silicon Motion, Wallace Kou. SSD PCIe 5.0 dominará el mercado hasta 2030: Silicon Motion lo confirma A pesar del interés que despiertan los avances tecnológicos, […]

Phison presenta su controladora SSD E28, capaz de ofrecer velocidades de 15 GB/s

En el marco de Computex 2025, Phison ha dejado una fuerte impresión al presentar su nuevo controlador M.2 NVMe Gen 5 de la serie E28, diseñado para el segmento de consumo, y con la capacidad de alcanzar los 15 GB/s. Phison presenta unidad SSD con velocidades de hasta 15 GB/s La compañía mostró una unidad de referencia equipada con este chip, […]

Las tecnologías MAMR y HAMR en la nueva generación de HDD

Con las tecnologías MAMR (Grabación Magnética Asistida por Microondas) y HAMR (Grabación Magnética Asistida por Calor), los discos duros están a punto de superar los 30 TB por unidad. Ambas tecnologías utilizan una fuente de energía adicional para posibilitar un cabezal de escritura más pequeño, lo que permite una mayor densidad de bits y pistas. […]

Crucial E100, el SSD M.2 PCIe 4.0 que competirá con los discos duros en precio ofreciendo más durabilidad y velocidad, ¡desde $155 pesos!

De un tiempo a esta parte los HDD han quedado relegados a los PC y servidores de todo el mundo como opciones para almacenamiento masivo dada su alta capacidad por euro invertido. Lo cierto es que esto va desde la gama de entrada hasta los mejores modelos y más rápidos, como el que presentó ayer Seagate […]

SSD M2 de 2 TB: qué configuraciones de SSD son más interesantes para tu PC

Rastreamos el mercado de SSD M.2 de 2 TB para concluir cuáles son las mejores configuraciones SSD posibles. Cuando decimos «configuraciones», venimos a referir a montar varios SSD en tu placa base para tener una capacidad total de 2 TB. Puedes optar por unidades de 500 GB, de 1 TB o comprar solo una unidad de 2 TB. Sin […]

Crucial E100, el SSD M.2 PCIe 4.0 que competirá con los discos duros en precio ofreciendo más durabilidad y velocidad, ¡desde 145 pesos!

De un tiempo a esta parte los HDD han quedado relegados a los PC y servidores de todo el mundo como opciones para almacenamiento masivo dada su alta capacidad por euro invertido. Lo cierto es que esto va desde la gama de entrada hasta los mejores modelos y más rápidos, como el que presentó ayer Seagate […]

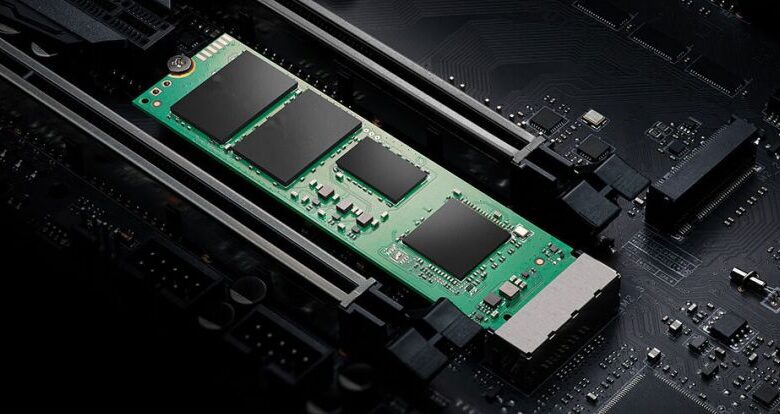

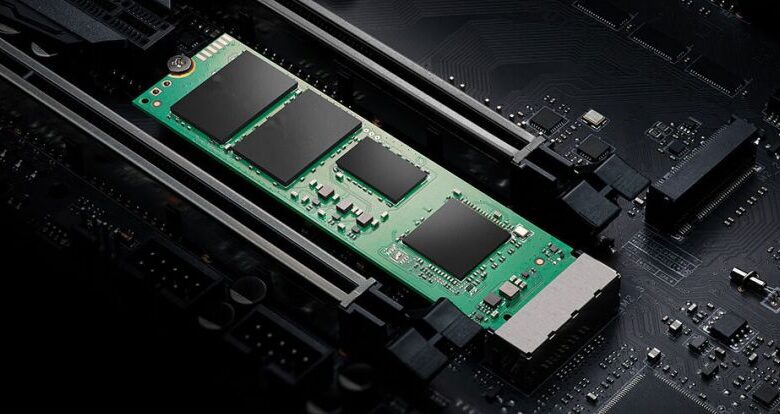

Tipos y formatos de discos SSD M.2, PCIe y NVMe

Tipos, clasificación, designaciones y modelos de memorias SSD M.2, conexiones PCIe y discos NVMe Hablemos de memorias SSD M.2, discos M.2 PCIe y M.2 NMVe, por lo que antes de nada creo que deberíamos entender bien qué son y qué tipos hay. Los discos SSD han revolucionado el panorama de la informática en los últimos 5 […]

Cómo convertir MBR a UEFI en Windows 11 sin perder datos

¿Te preguntas cómo convertir MBR a UEFI en Windows 11.? Cuando se trata de actualizar un sistema a Windows 11, uno de los requisitos esenciales es el uso del sistema de partición GPT en lugar de MBR. Este cambio es fundamental, ya que GPT es compatible con UEFI, lo que mejora el rendimiento del arranque y […]

Qué hacer si PC no detecta el SSD M.2

Cuando compras un nuevo SSD en formato M.2, lo más normal es instalarlo en la placa base y listo, pero se puede dar el caso de que la placa no lo detecte. No desesperes, porque en este artículo te vamos a contar por qué te puedes ver en esta situación y qué es lo que puedes hacer […]

Cómo acelerar tu unidad SSD y extender su vida útil: consejos y mitos

Windows detecta de forma automática el SSD que tenemos instalado y selecciona la configuración óptima para él. En la mayoría de los casos, no se requiere que tomemos ninguna acción adicional. Sin embargo, en Internet podemos encontrar una variedad de consejos para acelerar, optimizar y extender la vida útil de una unidad de estado sólido que no […]

Micron muestra la SSD PCIe 6.0 más rápida del mundo, que alcanza velocidades de 27 GB/s: el conmutador PCIe 6.0 de Astera Labs permite impresionantes lecturas secuenciales

La próxima generación de redes y almacenamiento está llegando a las ferias comerciales Micron y Astera Labs se unieron en DesignCon 2025 para mostrar los primeros SSD PCIe 6 del mundo en la naturaleza, junto con el conmutador de estructura de red Scorpio PCIe 6.0 de Astera. Cuando se conectaba a dos SSD PCIe 6.0 de […]

El mercado NAND se enfrentó a una pérdida de ingresos del 6,2% en el cuarto trimestre del 24 y las previsiones proyectan un impacto adicional del 20% en el primer trimestre de 25

La débil demanda de los consumidores parece ser la fuerza impulsora El último informe de TrendForce sugiere una disminución del 6,2% en los ingresos de NAND flash en el cuarto trimestre del año pasado, impulsado principalmente por la débil demanda de los consumidores. Los principales fabricantes de flash NAND se han enfrentado a una caída constante de los […]

Errores que matarán tu SSD antes de tiempo

Si desea que sus SSD duren muchos años sin problemas, debe dejar de hacerlos. Los SSD son dispositivos de almacenamiento ultrarrápidos y finamente ajustados que pueden aprovechar más el alto ancho de banda de PCIe 5.0 que incluso las tarjetas gráficas más rápidas. Pero como todos los instrumentos de rendimiento, no se puede tratarlos mal y […]

Por qué dos SSD son mejores que uno para tu PC

El ancho de banda de la competencia ralentizará las cosas, sin duda. Si está buscando acelerar su PC, debería considerar usar dos SSD en lugar de uno. Una forma de hacerlo es configurar las dos unidades en una matriz RAID 0. Esto permite combinar las velocidades de lectura y escritura de ambos SSD, lo que da como […]

3D NAND: Investigan tecnología de plasma que duplica la velocidad de grabado

Científicos están investigando unos nuevos métodos de almacenamiento 3D NAND más rápidos que nunca gracias a la tecnología de plasma. 3D NAND: Tecnología de plasma duplica la velocidad de grabado Se está investigando cómo la tecnología de plasma logra duplicar la velocidad de la transferencia y en la densidad de los módulos de memoria 3D NAND. Esta nueva […]

Análisis de la Kingston NV3: Increíble rendimiento de SSD en el mundo real por el precio

Este diseño sin DRAM muestra lo lejos que ha llegado la tecnología Host Memory Buffer: es muy rápida. La NV2 del año pasado de Kingston ofreció un gran rendimiento por su dinero en SSD. La NV3 de este año sigue siendo maravillosamente asequible, pero ha mejorado enormemente, incluso estableciendo un récord escribiendo nuestro archivo único de 450 […]

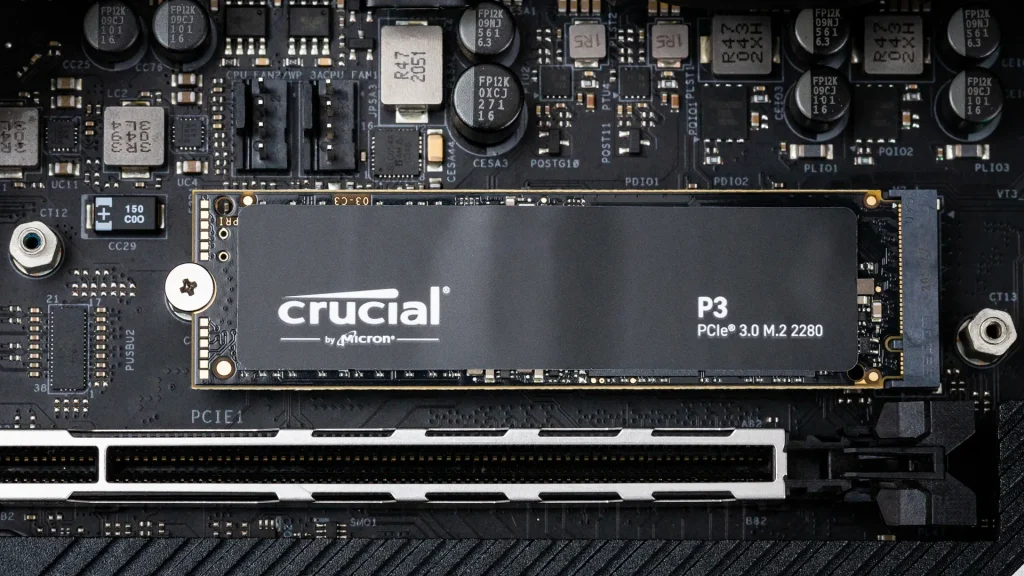

Análisis del SSD Crucial P3 Plus: Capacidad barata

El P3 Plus es un buen primer esfuerzo para un SSD económico más rápido con el nuevo QLC de Crucial. La Crucial P3 Plus es la primera unidad que hemos probado con el controlador E21T de Phison y el nuevo flash QLC de 176 capas de Micron. Con un precio inicial de solo 54 dólares […]

Análisis de la SSD Crucial P3: SSD secundaria sólida

El P3 es una unidad económica eficiente con capacidad de sobra La Crucial P3 es la hermana PCIe 3.0 de la P3 Plus. Utiliza el mismo controlador Phison E21T y está emparejado de manera similar con el flash QLC de 176 capas de Micron. Con un precio inicial de 74 dólares por 1 TB o 147 […]

El fabricante chino de chips bate récords: YMTC comienza a enviar silenciosamente TLC NAND 3D de 5ª generación

Yangtze Memory Technologies Co. (YMTC) ha comenzado silenciosamente a enviar su memoria NAND 3D de 5ª generación con 294 capas en total, así como 232 capas activas, y los analistas de TechInsights han logrado obtener estos circuitos integrados para su análisis, informes @Jukanlosreve. Resulta que YMTC ha aumentado con éxito la densidad de bits a los niveles de […]

¿Para qué se usa la memoria virtual de Windows y como se puede aumentar?

La memoria virtual de Windows (también conocida como ‘archivo de paginación’ o ‘archivo de intercambio’) es un área de la unidad de almacenamiento de un PC que el sistema operativo usa como si fuera memoria RAM. El uso de este tipo de memoria es automático y comienza cuando agotamos la cantidad de memoria RAM física. Sin […]

La IA duplicará las necesidades de almacenamiento en los próximos tres años

La IA duplicará las necesidades de almacenamiento en los próximos tres años, según una encuesta global de Recon Analytics para Seagate. Una encuesta a nivel mundial que se realizó a distintas empresas de almacenamiento basados en la nube arrojó unos resultados interesantes de car al futuro, sobretodo en lo que respecta a la implementación de la IA. Según la encuesta de Recon […]

Con estos 3 comandos tu SSD NVMe rendirá al máximo en Windows 11

Windows es un sistema operativo conocido por estar presente en millones de ordenadores alrededor del mundo. También se utiliza para servidores y estos suelen necesitar drivers distintos para ofrecer el mejor rendimiento posible. Pero un nuevo driver que Microsoft ha lanzado para que los dispositivos NVMe tengan un mejor funcionamiento en servidores, también se puede aplicar a las versiones de cliente. Los […]

Diferencia entre discos y unidades: NVMe, SATA, M.2 y U.2

Uno de los mayores cambios de los últimos años en el mundo del hardware, ha sido la llegada de las unidades de estado sólido o SSD (Solid State Drive). Gracias a unas velocidades de transferencia y de lectura mucho más rápidas que las de los discos duros tradicionales, ahora los ordenadores no solo arrancan en segundos, […]

Vea el estado de su SSD y otras estadísticas ocultas con esta herramienta gratuita

CrystalDiskInfo es una herramienta gratuita que puede brindarle información importante. ¿Alguna vez has mirado a tu gato mientras miraba una pared en blanco y pensó: «¿Qué está pensando?» Ciertamente lo he hecho, y también he hecho lo mismo con mi SSD: preguntándome si estaba funcionando bien, si se estaba calentando demasiado, si estaba sobrecargado de […]

¿Su SSD está a punto de morir? 10 señales de advertencia que no debes ignorar

Un SSD que está al final de su vida útil puede presentar todo tipo de signos y síntomas extraños. En 2024, casi todos los ordenadores modernos utilizan SSD como formato principal de almacenamiento de datos (excepto, quizás, los Chromebook económicos). Tal vez haya investigado para obtener los mejores SSD que valgan su dinero, equipando sus computadoras […]

¿Cuánto dura un SSD? Es una pregunta difícil de responder

¿Podrían estar contados los días de su antiguo SSD? He estado disfrutando de las velocidades ultrarrápidas de los SSD (unidades de estado sólido) para almacenar y restaurar datos desde hace un tiempo. Para los juegos, proporcionan tiempos de carga rápidos, admiten los gráficos más recientes y, como beneficio adicional, producen menos calor que los discos […]

Almacenamiento 5D mediante láser ultra-rápido en cristal

Cada vez se necesitan más y más capacidad de almacenamiento, y también cada vez unos accesos más rápidos y con menor latencia. La nueva tecnología de almacenamiento 5D mediante láser ultra-rápido en cristal podría ser un buen método para el futuro. Aquí podrás conocer con más detalle esta misteriosa y sorprendente tecnología. Especificaciones técnicas de los métodos […]

¿Qué es el sistema SMART de los SSD y cómo sacarle partido?

En esta guía te lo cuento todo acerca del sistema SMART de los SSD y lo que puedes hacer para sacarle todo el partido En esta guía voy a explicarte qué es el sistema SMART de los SSD y cómo puedes sacarle más partido. Aquí te hablo sobre los objetivos que cumple y cómo te […]

¿Qué es soft-sectored vs hard-sectored en un disco?

Las unidades de almacenamiento mecanico-magnético, es decir, los discos, aún siguen siendo algo desconocidos para muchos, ya que guardan algunos secretos. Por ejemplo, ¿sabías qué es el soft-sectored y en qué se diferencia con hard-sectored? Si no lo sabes, aquí te lo explicamos, además de otras cosas interesantes… ¿Qué significa soft-sectored? Cuando hablamos de sectores blandos y […]

Factores de forma de SSD explicados

Cambiar de una unidad de disco duro (HDD) a una unidad de estado sólido (SSD) puede ser confuso. Si ha determinado el tipo de desempeño que necesita y cuánto espacio de almacenamiento es necesario, es momento de encontrar un factor de forma que sea compatible con su sistema. Las unidades de estado sólido se definen […]

¿Por qué es malo comprar discos duros y SSD usados?

Muchas veces, contamos con el presupuesto justo y eso puede ser un problema a la hora de establecer nuestras expectativas. Somos muchos los que compramos los componentes sueltos y nos animamos a montarlos uno a uno. Sin embargo, comprar cierto hardware de segunda mano puede ser una mala decisión. Os mostramos qué componentes no tenéis que comprar o […]

Mitos y realidades de la fiabilidad de los SSD: su vida útil es (probablemente) más larga de lo que esperabas

Las unidades de estado sólido o SSD se han convertido de forma silenciosa en toda una revolución para el mundo de los PCs y portátiles, pero lo han hecho con algunas dudas. Una de las más frecuentes es esa leyenda urbana que parece apuntar a que la vida útil de estas unidades no es tan buena como la […]

NAND: SK Hynix enviará las primeras memorias de 321 capas en el primer trimestre de 2025

SK Hynix anuncia la producción de sus memorias flash NAND más avanzadas hasta ahora, que cuentan con 321 capas. NAND: Hynix enviará las primeras memorias de 321 capas en 2025 La producción de los módulos de memoria flash NAND de SK Hynix con 321 capas ya ha comenzado y los envíos se proyectan para el primer trimestre de 2025. Las nuevas memorias de 321 capas […]

La mejor selección de ofertas del Black Friday 2024

Ya está aquí la gran semana de compras del ‘Viernes Negro’ que celebramos con una gran selección de ofertas del Black Friday 2024 centrados en nuestro minorista de cabecera, Powertech Tecnologia, y unos descuentos que se elevan al 60% del precio de tarifa. Además de buenos descuentos y la garantía de que no te vas a ver envuelto en el ‘Black […]

WD amplía su oferta de SSD portátiles con nuevas SanDisk Extreme

Las SanDisk Extreme son una de las series de soluciones de almacenamiento externa y portátil más vendidas de la industria. WD, junto al lanzamiento de las SSD Black SN7100, ha anunciado una actualización importante de la serie. Los productos de almacenamiento basados en memorias flash NAND han terminado trasladando sus grandes ventajas frente a los discos duros desde […]

Revisión de Kingston NV2 SSD: Barato pero arriesgado

Un SSD económico genérico con hardware irregular La Kingston NV2 es uno de esos SSD que es demasiado bueno para ser verdad. El precio es excepcional, especialmente a 2 TB, y se vende como una unidad PCIe 4.0. Sin embargo, no tiene un hardware definitivo en su interior y su rendimiento para nuestras dos muestras […]

Qué buscar en un SSD externo

Más allá de la clasificación IP (robustez), el estilo y la portabilidad, todo lo que hay que tener en cuenta para un SSD externo es el bus en el que se ejecuta. Las SSD USB de 5 Gbps (3.x) están limitadas a 550 MBps, las SSD USB (3.1) de 10 Gbps alcanzan un máximo de […]

Qué buscar en un SSD interno

NVMe o SATA Solo busque SATA si su computadora o dispositivo no es compatible con NVMe, que es mucho más rápido. Tenga en cuenta que una ranura M.2 en una computadora antigua podría ser mSATA en lugar de NVMe. Lea la guía del usuario o el manual para ver si es compatible con NVMe/NVMe-bootable. Deben […]

V-NAND: Samsung anuncia la 10a generación con 400 capas gran salto en la capacidad de almacenamiento SSD

V-NAND: Samsung anuncia la 10a generación con 400 capas Las próximas memorias flash para el almacenamiento en estado sólido, V-NAND, se están anunciado con unas 400 capas, utilizando una unión vertical con el que están convencidos que podrán aumentar las capacidades de almacenamiento, con la idea de llegar en un futuro hasta las 1000 capas. Estas […]

SSD PCIe 3.0: Los fabricantes van a descontinuar estas unidades para centrarse en PCIe 4.0/5.0

Los grandes fabricantes de SSD parece estar abandonando aquellas unidades con interfaz PCIe 3.0, centrándose en las unidades PCIe 4.0 y PCIe 5.0 SSD PCIe 3.0: Los fabricantes van a descontinuar estas unidades Según informa el medio STH (ServerTheHome), los fabricantes de SSD están de acuerdo en que las unidades SSD PCIe 3.0 van a dejar […]

Las marcas chinas de SSD se encuentran entre las cinco primeras en términos de cuota de mercado: Kingston mantiene su lugar como el mayor fabricante de SSD del mercado

Los cinco principales líderes de la industria de SSD aumentaron su cuota de mercado del 59% en 2022 al 72% en 2023 Los fabricantes chinos de SSD están haciendo olas en el mercado de SSD debido a la alta demanda y soporte local, según un informe de TrendForce. Sin embargo, a pesar de la creciente competencia […]

Qué buscar en un SSD interno

NVMe o SATA Solo busque SATA si su computadora o dispositivo no es compatible con NVMe, que es mucho más rápido. Tenga en cuenta que una ranura M.2 en una computadora antigua podría ser mSATA en lugar de NVMe. Lea la guía del usuario o el manual para ver si es compatible con NVMe/NVMe-bootable. Debería […]

SSD PCIe 3.0: Los fabricantes van a descontinuar estas unidades para centrarse en PCIe 4.0/5.0

Los grandes fabricantes de SSD parece estar abandonando aquellas unidades con interfaz PCIe 3.0, centrándose en las unidades PCIe 4.0 y PCIe 5.0. SSD PCIe 3.0: Los fabricantes van a descontinuar estas unidades Según informa el medio STH (ServerTheHome), los fabricantes de SSD están de acuerdo en que las unidades SSD PCIe 3.0 van a dejar de fabricarse para […]

Análisis de CRUCIAL P3 2 TB

Con la creciente demanda de soluciones de almacenamiento más rápidas y potentes para los sistemas modernos, Crucial ha desarrollado una solución que cumple con los exigentes requisitos con el SSD P3. El Crucial P3 es un SSD M.2 de factor de forma 2280 con una capacidad de 2 TB y utiliza la interfaz PCIe 3.0 […]

Análisis del SSD Patriot P300 M.2 NVMe: Precio bajo, sin flores

El P300 de Patriot es asequible, compacto y bastante eficiente Patriot ha estado en llamas últimamente, lanzando algunos SSD atractivos. El Viper VP4100 de la compañía es uno de los más rápidos que el dinero puede comprar, y el Viper VPR100 ofrece un sólido rendimiento PCIe Gen 3 con una iluminación RGB de buen gusto. Pero, si bien estos […]

Discos duros: Se espera que en 2028 alcancen los 60 TB de capacidad

Discos duros: Alcanzaría los 60 TB de capacidad en 2028 Una hoja de ruta ha sido publicada por la IEEE para dispositivos y sistemas de almacenamiento masivo de datos revela que los discos duros con capacidades de hasta 60 TB están previstos para el año 2028. La última hoja de ruta de desarrollo de discos duros de la […]

Samsung pone en marcha la producción de su SSD más veloz para PCs

La firma surcoreana Samsung ha anunciado hoy el pistoletazo de salida de la producción en masa de su unidad SSD más veloz para PCs. Según la compañía, la unidad basada en PCIe 5.0, cuyo nombre de modelo es PM9E1, ofrece el mayor rendimiento y la mayor capacidad del sector. El fabricante ha afirmado que la memoria extraíble se basa en el controlador […]

SSD o HDD para almacenamiento de datos: diferencias y cuál es la mejor opción

El sistema de almacenamiento es esencial para guardar información de manera masiva, y los discos externos se destacan como una de las mejores opciones. Aunque muchos ordenadores actuales vienen equipados con SSD, los HDD continúan siendo una opción popular en el mercado debido a sus ventajas en precio y capacidad de almacenamiento. Si estás pensando montar tu propio ordenador o […]

Intel Optane, análisis: la alternativa al SSD que quiere ser mucho más

Los SSD han supuesto tal revolución en el almacenamiento de nuestros PCs que las tecnologías que las diferentes compañías proponen como alternativa las acogemos con bastante entusiasmo. Es el caso de las Intel Optane, memorias no volátiles con tecnología 3D Xpoint. ¿Son en realidad la revolución que prometen? Así funcionan las memorias Intel Optane Intel […]

Cómo sacarle el máximo rendimiento a la PS5 Pro con un SSD de Kingston

Con el lanzamiento de la PS5 Pro a la vuelta de la esquina, previsto para el próximo 7 de noviembre, los jugadores no solo quieren un mayor rendimiento, sino también optimizar el espacio de almacenamiento para los juegos más modernos. La consola no tiene una capacidad interna ilimitada. Si se tiene en cuenta que cada vez […]

MTE730P: nuevo SSD Industrial PCIe M.2 22110 de Transcend con Power Loss Protection

Transcend ha anunciado su primer SSD PCIe M.2 22110 de grado industrial, el MTE730P. Este SSD cuenta con la tecnología Power Loss Protection (PLP), asegurando la integridad de los datos incluso en los entornos más exigentes. Con un rendimiento PCIe Gen 4 y capacidades de hasta 4 TB, la MTE730P satisface las necesidades de la automatización […]

Kingston KC600 1 TB, review: un SSD SATA3 rápido y económico

A pesar que, actualmente el mercado está copado de nuevos lanzamientos de SSDs PCIe NVMe, en realidad los que más se venden, siguen siendo los de formato de 2.5 pulgadas e interfaz SATA 3, precisamente porque sus precios están ahora mismo en mínimos. Hoy os presentamos el análisis del nuevo Kingston KC600 que se presenta justo en el […]

SSD PCIE 5.0: características y novedades

Presentados los SSD PCI Express 5, los nuevos discos duros de estado sólido que acelerarán los accesos a datos en los próximos años. Y lo hacen no solo con mayor rendimiento, sino con algunas novedades que deberías conocer. Por eso, aquí te resumimos todas las características de estos SSDs tan sorprendentes que han dejado muy buenas sensaciones en […]

Crucial P310: Lanzan nuevas variantes en formato 2280 de hasta 2 TB

Crucial está lanzando la versión 2280 de su flamante SSD P310, que hasta ahora solo venia en su variante 2230. Crucial P310 salta hacia el formato 2280 con hasta 2 TB El SSD Crucial P310 es considerado uno de los mejores SSD del mercado dentro del formato 2230, que ahora está migrando hacia el formato 2280, qué es el más tradicional que conocemos en PC. […]

Tipos Charge Trap NAND Flash: BiCS, P-BiCS, VRAT, Z-VRAT, VSAT, A-VSAT, TCAT, V-NAND

La memoria flash de tipo NAND se presenta bajo diferentes tecnologías de transistores, como las de la puerta flotante o las de trampa de carga. En este artículo nos centraremos en ésta segunda tecnología, y veremos los tipos que existen dentro de esta familia, entre ellas la conocida como V-NAND de la que tanto se […]

El SSD sin DRAM económico de Micron podría significar el fin de las unidades SATA de bajo rendimiento: revisiones independientes muestran que supera al 990 EVO de Samsung en los puntos de referencia populares

DRAMless SSD es un vistazo al futuro Micron presentó recientemente su SSD de cliente 2650, el primero que se fabrica con NAND 3D de 276 capas, un nuevo récord para la compañía. La NAND Gen 9 ofrece la velocidad de E/S más rápida del sector con 3,6 GBps, que según Micron es un 50% más […]

El firmware de la SSD Crucial MX500 es susceptible a una vulnerabilidad de seguridad de desbordamiento de búfer

Las SSD MX500 se pueden explotar a través de ataques de desbordamiento de búfer Se ha descubierto una vulnerabilidad de seguridad en las SSD MX500 de Crucial, lo que permite la fuga de datos que podría exponer datos confidenciales. Un usuario en los foros de TechPowerUp descubrió que el MX500 es vulnerable al desbordamiento del búfer, lo que hace […]

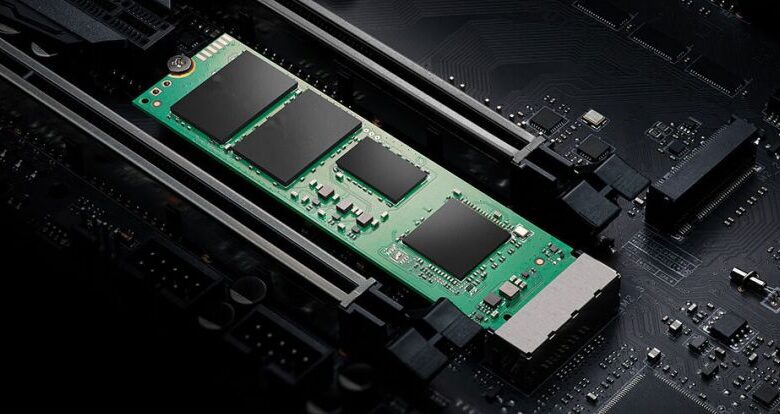

SSD M.2 SATA y NVMe: toda la información y modelos recomendados

Hoy hablaremos todo sobre M.2. Las M.2 que anteriormente se les conocían con el nombre de NGFF, y es que son los sustitutos de los ya viejos mSata, creando discos muchísimos más pequeños y con mayor capacidad. El objetivo principal de estas unidades SSD, es brindar soluciones prácticas y rápidas cuando el almacenamiento “colapse”. En un principio, eran alternativas […]

Lo que debe saber sobre el SSD M.2 SATA

A medida que la tecnología evoluciona, la demanda de soluciones de almacenamiento de datos más rápidas y eficientes sigue creciendo. Entre las opciones de almacenamiento más populares y avanzadas disponibles en la actualidad se encuentra la Unidad de estado sólido (SSD), y más específicamente, el SSD M.2 SATA. Este tipo de SSD se ha vuelto cada vez […]

¿Cuál es la diferencia entre los SSD empresariales y los SSD para consumidores?

En el panorama digital actual, las unidades de estado sólido (SSD) se han convertido en un componente crucial tanto para las empresas como para los consumidores individuales. Si bien la función principal de una SSD Si bien el propósito de los SSD de nivel empresarial es almacenar y recuperar datos, los requisitos de los SSD de nivel […]

Parece una gráfica, pero es una tarjeta para crear un RAID con unidades M.2

Existen muchas formas de almacenar nuestros datos, pero no todas ofrecen las mismas características, lo que hace que en muchas ocasiones tengamos que decidir sobre cual es mejor para lo que necesitamos. Es por ello que siempre existen soluciones para todo tipo de casos, y ahora HighPoint ha presentado una nueva tarjeta de expansión creada […]

Cómo funciona y para qué sirve el controlador del SSD

Cuando leemos la especificación de una unidad de almacenamiento sólido, tan importante como el tipo de memoria NAND que emplea en su interior para almacenar nuestros datos, es saber cuál es el controlador del SSD que el fabricante ha decidido instalar en su interior. Pero ¿sabemos qué es este controlador y cómo se emplea en […]

Por qué está soldada la memoria RAM o SSD en portátiles

Muchos portátiles, especialmente algunos de pequeño tamaño o ultrabooks, es frecuente que tengan la memoria RAM soldada, al igual que los chips de memoria flash que sustituyen al SSD en formato módulo. Aquí te explicamos por qué esto es así, las ventajas que puede tener, y las desventajas, para que puedas conocer bien a qué atenerte… LPDDR, […]

SSD baratos claves para elegir correctamente

Las unidades SSD se han impuesto a las HDD, aunque éstas últimas no han muerto aún. Y es que, el nuevo almacenamiento de estado sólido ofrece una serie de ventajas respecto a las unidades mecánico-magnéticas. No obstante, no todo son ventajas, y uno de los principales problemas es el precio por unidad de capacidad. Por […]

SSD chinos cuidado con ellos

Las unidades de almacenamiento flash son caras, esto no es ningún secreto. Y aunque cada vez van teniendo mayores capacidades y su precio va disminuyendo en relación €/bit almacenado, aún pueden estar fuera del alcance de algunos. Por eso muchos usuarios están empezando a mirar hacia los SSD chinos, pero cuidado con estas unidades que son […]

SSD empresariales frente a SSD de consumo: diferencias notables

Ya sea que esté configurando computadoras portátiles, de escritorio o servidores, hay pocos componentes que sean más importantes que el dispositivo de almacenamiento (generalmente llamado disco duro). Obtener un disco duro de buena calidad no solo ayudará a garantizar que sus datos estén protegidos, sino que también tendrá un impacto dramático en la rapidez con […]

Comprender las diferencias entre los SSD SATA y mSATA

Las unidades de estado sólido (SSD) han ganado una inmensa popularidad en los últimos años debido a su rendimiento y confiabilidad superiores en comparación con las unidades de disco duro (HDD) tradicionales. Al elegir un SSD, es importante tener en cuenta los dos tipos principales disponibles: SATA y mSATA. Si bien ambos ofrecen beneficios sustanciales […]

¿Cuánto tiempo de vida útil tiene un SSD?

¿Cuánto tiempo de vida útil tiene un SSD? ¿Y cómo es posible que podamos saber aproximadamente cuál es la vida útil de una unidad antes de comprar un SSD? Muy sencillo: los fabricantes han desarrollado pruebas de resistencia para los SSD con el objetivo de someter a una carga de trabajo extrema a sus dispositivos, y en función […]

Qué significa el TBW de un SSD y si es importante

En este post, hablaremos de qué es el TBW de un SSD. También te haremos saber cómo determinar si el TBW de un SSD es adecuado para tus necesidades a la hora de comprar un SSD. Así que estad atentos ¿Qué es el TBW? TBW significa Terabytes escritos. También se puede denominar «resistencia». Es una […]

Mejora el rendimiento de tu SSD con este sencillo truco

Actualmente cualquiera que compra un ordenador nuevo lo hace con un disco duro SSD. Estas unidades nos ofrecen un gran rendimiento y tienen características geniales, como su elevada resistencia. Pero, hay una cosa que seguro que no sabes de los SSD y es la importancia del comando TRIM y su papel fundamental en estas unidades de almacenamiento. Los SSD […]

Aprovechando la potencia de PCIe 5.0

Las SSD PCIe 5.0 serán el futuro estándar de oro para el almacenamiento de datos, para jugadores, creadores y profesionales de máximo rendimiento que quieran formar parte de la revolución de próxima generación en juegos y creación de contenidos. Aprovechando la potencia de PCIe 5.0, las SSD Gen5 prometen: Los tiempos de transferencia de datos […]

El SSD sin DRAM económico de Micron podría significar el fin de las unidades SATA de bajo rendimiento: las revisiones independientes muestran que supera al 990 EVO de Samsung en los puntos de referencia populares

Micron presentó recientemente su SSD de cliente 2650, el primero que se fabrica con NAND 3D de 276 capas, un nuevo récord para la compañía. La NAND Gen 9 ofrece la velocidad de E/S más rápida de la industria, con 3,6 GBps, que según Micron es un 50% más rápida que el envío de NAND […]

¿Debo particionar un SSD en varias unidades?

¿Es bueno particionar un SSD? Dado que la capacidad de las unidades SSD es cada vez mayor, cada vez más personas se preguntan si es necesario particionar una unidad SSD. Puede encontrar la respuesta en el artículo. ¿Debo particionar SSD? Cuando tengamos un nuevo SSD (disco duro de estado sólido), ¿será mejor que lo particionemos como […]

Kingston prepara un nuevo SSD M.2 económico: NV3 cuenta con interfaz PCIe 4.0 para velocidades de hasta 6 GB/s

Pero, ¿hereda la Kingston NV3 el mismo defecto que su iteración anterior, la NV2? Kingston ha catalogado la NV3 como el nuevo SSD PCIe 4.0 de la compañía. La compañía anuncia la próxima NV3 para «necesidades de almacenamiento de alta velocidad y bajo consumo» con capacidades de almacenamiento entre 500 GB y 4 TB. Actualmente, […]

Análisis del SSD Patriot Viper VP4300 Lite de 4 TB: Capacidad a un coste

El Patriot Viper VP4300 Lite lo tiene todo, sobre el papel, enfrentándose a los mejores SSD. Ofrece hasta 4 TB de bondad de un solo lado capaz de más de 7 GB/s de rendimiento, y además de todo eso, es económico. Iguala a su rival y a nuestro mejor SSD económico, el Teamgroup MP44, en casi todas […]

Si vas a comprar un SSD, hazlo ahora: se van a disparar de precio en 2024

Las unidades SSD han comenzado a valer más dinero en las últimas semanas de 2023, y todo apunta a que aumentarán otro 40 o 50% en 2024. La razón es la subida de precio de las memorias flash NAND, que los SSD usan para almacenar los datos. Llevo meses haciendo un seguimiento a un SSD M.2 de 1 […]

Los actualizadores de SSD toman nota, los analistas esperan una caída de precios de hasta el 13% durante el tercer trimestre

los analistas esperan una caída de precios de hasta el 13% durante el tercer trimestre TrendForce, la firma de inteligencia de mercado de alta tecnología, ha publicado una actualización sobre el mercado flash NAND. Sus últimas previsiones prevén que el precio de venta promedio (ASP) de NAND flash caiga entre 3 y 8% en el tercer […]

Kingston agrega nueva capacidad para el SSD NV2, almacenamiento y productividad con velocidad PCIe 4.0

SSD NV2 Kingston PCIe 4.0 NMVe Kingston Technology Company, el fabricante independiente de productos de memoria líder en el mundo, anunció hoy una nueva capacidad para los SSD NV2 PCIe 4.0 NVMe, una gran solución de almacenamiento de última generación con controlador Gen 4×4 NVMe, velocidades de lectura/escritura de hasta 3500/2800 MB/seg1, con menor consumo […]

Discos Duros

Unidades de almacenamiento En Life Informàtica somos expertos en tecnología, encuentra una amplia variedad de discos duros al mejor precio. Imprescindible tanto para aquellos usuarios que requieren una rápida y segura capacidad de almacenamiento y de más experimentados. Almacena y accede a tus datos de manera eficiente y sin preocupaciones. Adquiere un dispositivo de almacenamiento de primera […]

Discos Solido Kingston A400 vs KC600

Kingston A400 Vs KC600 El Kingston KC600 y el Kingston A400 no son una competencia directa entre sí, sino que las dos series de SSD SATA se complementan entre sí en la cartera del fabricante. Pero, ¿dónde están las diferencias entre las dos unidades de Kingston en comparación? ¿Para qué tipo de usuario es más adecuado el […]

Mi experiencia usando un disco solido

Usando un disco solido Evolución Poco a poco vamos viendo el andar de la tecnología, en cuanto a los discos solidos se refiere, con interfaz pcie 3.0 y ahora pcie 4.0 con lo que han logrado aumentar el rate de transferencia. en cuanto a los que utilizan conexion sata la evolucion llega a mejorar los […]

Caddy y el disco solido

Caddy adaptador Errores y técnicas Los hay de diferentes marca y formas, pero su finalidad es la misma darle una segunda oportunidad al espacio utilizado por aquellas unidades de cd rom, dvd o dvd rw dispuestas en computadores portatiles de hace algunos años. La conversion del cd al espacio utilizado por un disco solido o […]