Discos duros, de los Megabytes a la era Terabyte y más allá

La trayectoria de los discos duros (HDD) es de más de 60 años y en ella hemos podido ver la transformación desde voluminosos dispositivos de baja capacidad a soluciones de alta densidad a un coste efectivo. Los primeros HDD, surgidos en la década de 1950, tenían el tamaño de un armario, pesaban casi una tonelada y revolucionaron el procesamiento de datos al permitir un acceso más inmediato a la información a determinados sistemas informáticos y mainframes. Sin embargo, el verdadero triunfo del disco duro comenzó en la década de 1980 con la llegada de los PC. Discos duros: evolución inicial y estandarización En los primeros años del PC, las unidades HDD de 5,25 pulgadas apenas ofrecían unos pocos Megabytes (MB) de almacenamiento como los populares modelos de 20MB. En aquel momento, esa capacidad era suficiente debido a la ausencia de interfaces gráficas y contenidos digitales que demandaran más espacio. Con el paso del tiempo, las capacidades de almacenamiento aumentaron rápidamente hasta alcanzar las centenas de MB, junto con la estandarización de interfaces. El conector Molex se convirtió en el estándar para la alimentación, mientras que Parallel ATA (PATA) y posteriormente Serial ATA (SATA) dominaron la transferencia de datos, reemplazando los antiguos cables planos. Durante este período, también la industria se consolidó rápidamente. En 1985 había 75 fabricantes de discos duros y más de 200 compañías intentaron producirlos en algún momento. Actualmente quedan tres, ya que la producción solo es rentable a gran escala. La trayectoria de los discos duros (HDD) es de más de 60 años y en ella hemos podido ver la transformación desde voluminosos dispositivos de baja capacidad a soluciones de alta densidad a un coste efectivo En paralelo, los factores de forma de los HDD se redujeron de manera constante. Los discos de 3,5 pulgadas se popularizaron a finales de los años 80, adaptándose a las bahías de disquete y convirtiéndose rápidamente en el estándar para servidores y sistemas de almacenamiento, una posición que mantienen hasta hoy. Posteriormente surgieron formatos más pequeños, como los discos de 2,5 pulgadas para portátiles, aunque ahora se encuentran principalmente en unidades externas USB debido al dominio de los SSD en los portátiles. Aparecieron incluso discos aún más pequeños como los HDD de 1,8 pulgadas (utilizados en el primer iPod en 2001) y los de 1 pulgada (para ranuras CompactFlash en cámaras digitales). A principios de los 2000, algunos teléfonos inteligentes llegaron a incorporar modelos de apenas 0,85 pulgadas con una capacidad de 4GB. Sin embargo, la memoria flash terminó imponiéndose en los dispositivos móviles, marcando un límite inferior para la reducción de tamaño físico de los HDD. Más capacidad: PMR, helio y tecnología de microondas El boom de la memoria flash obligó a los discos duros HDD a diferenciarse ofreciendo altas capacidades a bajo coste. Un salto importante se produjo con la grabación magnética perpendicular (PMR) a mediados de los 2000. A diferencia de la grabación longitudinal (LMR), que alineaba los bits horizontalmente, la PMR los organizaba de manera vertical, aumentando de forma considerable la densidad de almacenamiento. Posteriormente, a mediados de la década de 2010, se logró otro avance al llenar los discos con helio. Este gas inerte y ligero reduce la fricción y la turbulencia en comparación con el aire, lo que permite el uso de discos más delgados y la incorporación de más platos en la misma carcasa. Con nueve discos y PMR, esta innovación permitió la fabricación de unidades de hasta 16TB. Más recientemente, la grabación magnética asistida por microondas (MAMR) ha surgido como una nueva técnica. Esta tecnología emplea microondas para controlar y enfocar el flujo magnético en el cabezal de escritura, lo que reduce la energía necesaria para magnetizar los bits y posibilita cabezales más pequeños y una escritura más densa. Toshiba lanzó unidades con una variante denominada MAMR de flujo controlado (FC-MAMR™), que incrementó la capacidad de almacenamiento y mejoró la eficiencia energética. La Serie MG10, presentada en 2022, cuenta con un diseño rellenado con helio de 10 discos capaz de almacenar hasta 22TB manteniendo el formato de 3,5 pulgadas. El futuro de la tecnología de discos duros Sobre la base de la tecnología FC-MAMR, Toshiba presentó en 2024 la familia Mx11 de discos duros empresariales con helio. Esta innovación demuestra el potencial para aumentar la capacidad sin incrementar el consumo energético. La Serie MG11 utiliza grabación magnética convencional (CMR) con FC-MAMR para alcanzar capacidades de hasta 24TB. Por su parte, la Serie MA11 emplea grabación magnética escalonada (SMR), que permite alcanzar capacidades de hasta 28TB. SMR escribe datos en pistas que se solapan parcialmente, incrementando la densidad y la capacidad total de cada disco. CMR es ideal para servidores empresariales que manejan cargas de trabajo variadas, mientras que la industria se orienta hacia SMR para cargas homogéneas que escriben grandes volúmenes de datos secuenciales, utilizando memorias caché optimizadas para absorber escrituras aleatorias cortas. La siguiente fase será la grabación magnética asistida por microondas con conmutación (MAS-MAMR), que activará el material de los discos mediante microondas para reducir aún más el consumo de energía y permitir cabezales de escritura más pequeños. Esto requiere nuevos recubrimientos del disco y una conmutación de microondas más precisa. Combinada con SMR avanzado y discos más delgados (ahora de 0,55 mm, lo que permite 11 discos en una carcasa de 3,5 pulgadas), MAS-MAMR podría elevar la capacidad de los HDD a unos 40TB en los próximos años. De hecho, Toshiba ya ha presentado un prototipo de 11 discos con 31,24TB. Más adelante, la tecnología de grabación magnética asistida por calor (HAMR) ofrecerá aún mayor potencial. HAMR utiliza un diodo láser para calentar el material magnético hasta su punto de Curie, lo que permite alinear los bits con muy poca energía magnética. Mientras que MAMR incrementa principalmente la densidad lineal, HAMR se centra en aumentar la densidad de las pistas. La previsión es que HAMR permita unidades de más de 40TB, e incluso de hasta 50TB, en los próximos años, asegurando que los HDD sigan siendo la base del almacenamiento de datos

Cómo probar la RAM: asegurarse de que la mala memoria no bloquee su PC

Si tiene un caso desagradable de BSOD que no desaparece, debe verificar si su RAM no está defectuosa. La RAM es un componente vital que garantiza el correcto funcionamiento de un sistema. En términos simples, la RAM funciona como memoria a corto plazo, donde su sistema almacena información temporalmente mientras trabaja en una tarea. Por lo tanto, la memoria defectuosa puede afectar gravemente su trabajo. Por lo general, la RAM dura más que la mayoría de los otros componentes internos, a menos que esté actualizando de un estándar más antiguo a uno más nuevo, como DDR4 a DDR5. Si bien la falla de RAM es rara, puede suceder. Como cualquier pieza de la computadora, incluso la mejor RAM eventualmente fallará, por lo que es importante saber qué hacer cuando llegue ese momento. Por lo general, la RAM no deja de funcionar repentinamente sin previo aviso. Por lo general, hay indicadores tempranos de un DIMM defectuoso o defectuoso. Sin embargo, recibir RAM DOA (muerta al llegar) no es inusual, al igual que cualquier otro componente de PC. Los signos comunes de mala RAM incluyen pantallas azules aleatorias de la muerte (BSOD), fallas o reinicios del sistema, bloqueos del sistema operativo y falta de memoria. En casos severos, es posible que su sistema ni siquiera publique y produzca múltiples pitidos. Antes de ejecutar cualquier diagnóstico en su RAM, asegúrese de que esté funcionando con la frecuencia estándar. Muchos usuarios ejecutan kits de memoria Intel XMP 3.0 o AMD EXPO, por lo que es importante distinguir entre un overclock inestable y un DIMM o DIMM defectuosos. Un overclock inestable puede producir síntomas similares a la RAM defectuosa. Por lo tanto, el primer paso para diagnosticar una memoria defectuosa es restablecer su sistema a su configuración predeterminada. Puede hacer esto restableciendo el firmware a los valores predeterminados en el BIOS de su placa base o presionando el botón dedicado «Borrar CMOS» en el panel posterior de algunas placas base. En los tiempos modernos, no esperamos que nadie tenga un solo DIMM en su sistema. Lo más probable es que utilicen al menos una configuración de doble canal. Cuando hay varios DIMM, es más fácil diagnosticar cada uno por separado. De lo contrario, no sabrá qué DIMM es el defectuoso, incluso si el software informa un error, se convierte en un proceso de eliminación. Hasta donde sabemos, solo una pieza de software en el mercado puede identificar con precisión qué DIMM específico tiene circuitos integrados (IC) defectuosos, que discutiremos más adelante. El mejor software para identificar RAM defectuosa varía según a quién le pregunte. Según nuestra experiencia, probar su RAM con al menos dos programas diferentes debería ser suficiente. Existe la posibilidad de que un programa no detecte un DIMM defectuoso, pero es poco probable que engañe a dos probadores diferentes. Por supuesto, si sus resultados son negativos pero aún sospecha fuertemente de un mal DIMM, no estaría de más obtener una tercera opinión. Todo el software que hemos reunido es gratuito. El pago desbloquea opciones adicionales, pero la versión básica es más que suficiente para diagnosticar DIMM defectuosos. También hay otras opciones disponibles. Curiosamente, el software para detectar DIMM defectuosos también es popular entre los overclockers que evalúan la estabilidad de la memoria. Aunque estamos usando DDR5 para esta guía, sigue siendo aplicable a formatos más antiguos como DDR4 y anteriores. Cómo probar la RAM con HCI Memtest HCI Memtest es uno de los programas más simples y fáciles para detectar errores de RAM. Desafortunadamente, la versión básica tiene solo una sección modificable por el usuario donde ingresa la cantidad de RAM para probar y el software se encarga del resto. Una de sus limitaciones es que solo puede probar entre 2 GB y 3,5 GB de RAM por instancia, lo que puede ser problemático cuando se prueban grandes cantidades de RAM o un procesador con muchos hilos. Para realizar pruebas óptimas, es mejor medir la cantidad total de RAM distribuida en todos los subprocesos del procesador. Esto implica abrir una instancia de Memtest por subproceso. Es cierto que probar la RAM con procesadores que tienen muchos hilos puede convertirse en una molestia. Sin embargo, la versión Pro de HCI Memtest cuesta solo $ 5 y automatiza todo el proceso. Además, algunas herramientas de envoltura pueden realizar un trabajo similar con la versión gratuita si las busca en línea. 1. Descargue HCI Memtest y extraiga su contenido del archivo ZIP. 2. Ejecute memtest.exe. Es el único ejecutable en la carpeta, por lo que es poco probable que cometa un error. 3. Abra el Administrador de tareas de Windows y observe la cantidad de RAM libre disponible. 4. Divida la RAM libre por el número total de subprocesos del procesador. 5. Inicie el mismo número de instancias de Memtest que los subprocesos de su procesador e ingrese el resultado del paso anterior en cada una. Por ejemplo, estamos probando 16 GB de memoria en nuestro sistema Core i9-13900K. El procesador tiene 32 hilos, por lo que ejecutamos 32 instancias de Memtest. Teníamos aproximadamente 13,79 GB libres, lo que se traduce en 431 MB por instancia. Dependiendo de su procesador y cantidad de memoria, un pase completo tarda aproximadamente una hora. Sin embargo, una o dos pasadas deberían ser suficientes para identificar la RAM defectuosa. Cómo probar la RAM con TestMem 5 TestMem ha existido desde la era de DOS. Lanzado en 1998, ha experimentado una evolución significativa a lo largo de los años y ahora se encuentra en su quinta versión. TestMem 5 ofrece 16 pruebas, que los usuarios pueden personalizar ampliamente. El software es liviano y presenta una interfaz simple y amigable para principiantes. A diferencia de HCI Memtest, TestMem 5 es totalmente gratuito. Admite configuraciones de usuario personalizadas, lo que proporciona infinitas opciones de prueba. Entre los entusiastas y los overclockers, los ajustes preestablecidos Extreme y Absolut del usuario Anta777 son particularmente populares. 1. Descargue TestMem 5 y extraiga el archivo ZIP en su escritorio. 2. Haga clic con el botón derecho en el archivo ejecutable «TM5» y ejecútelo con privilegios de administrador. 3. Haga clic en el botón «Cargar configuración y salir» para cargar

¿Desaparecerán los HDD pronto? ¿Solo usaremos SSD?

Los HDD nos han acompañado desde hace décadas, y por el momento siguen, incluso tras la aparición de los SSD y su superioridad técnica. Otros medios han desparecido, han quedado obsoletos, como los disquetes o algunos medios ópticos, casetes, etc., ¿le pasará lo mismo a los HDD o aún tienen mucho recorrido por delante? Actualidad En 2025 los fabricantes de HDD muestran señales claras de renovación tecnológica y recuperación de demanda. Por ejemplo, Seagate reportó un crecimiento impulsado por la adopción de sus unidades HAMR en clientes empresariales o que necesitan almacenamiento a gran escala, como los centros de datos para la nube. Algo similar ha ocurrido a otras compañías, como Western Digital. Ten en cuenta que tanto Seagate, como WD y Toshiba, mantienen sus roadmaps para seguir aumentando las capacidades de sus HDDs por encima de los 50 TB con nuevas tecnologías, a la par que reducen el tiempo de acceso y reducen el precio por unidad de almacenamiento. A pesar de las claras ventajas de los SSD, su precio y capacidad limitada, ha hecho que los HDD sigan siendo un gran mercado. Además, ten en cuenta que existen algunos sectores que aún siguen dependiendo bastante de las unidades HDD, como los sistemas de videovigilancia, NAS, etc., aunque poco a poco los SSD se abran camino… Motivos para la supervivencia de los HDD En resumen, los HDDs seguirán por muchos años más, y tendrán que convivir con los SSDs. Aunque en el sector doméstico es probable que las unidades HDD tengan cada vez menos sentido, dadas las capacidades de los SSD, en aplicaciones donde se necesite capacidad a gran escala, los HDDs siguen siendo la única opción de momento: Dinámica de los SSD: ¿amenaza existencial o complemento? Los SSD han mejorado velocidad, resistencia y coste por bit, y tecnologías como QLC/PLC han comprimido la brecha de precio. Además, nuevos empaquetados 3D han permitido amontonar chips NAND para conseguir capacidades cada vez superiores. Para cargas intensivas en IOPS y en latencia crítica, como bases de datos transaccionales, sistemas en memoria, caches de IA, etc., los SSD van a sustituir al completo a los HDDs. Sin embargo, a escala masiva el coste por TB y la capacidad absoluta que ofrecen los HDD siguenfavoreciendo su presencia en la jerarquía de almacenamiento. La conclusión técnica es que SSD y HDD resuelven problemas diferentes: el SSD es la capa de rendimiento; el HDD, la capa de capacidad coste-eficiente. Eso sí, los nuevos ultrabooks y AIO, así como miniPCs, poco a poco han eliminado la posibilidad de instalar HDDs, por lo que no queda otra que optar solo por SSDs. En el PC de sobremesa, aunque aún existe la posibilidad, sí que es verdad que cada vez es más raro ver unidades HDD como primarias, y se han visto relegadas a unidades secundarias donde no se ejecuta software alguno, o también en unidades externas para copias… Lo que intento decir con esto es que es más probable que los HDDs desaparezcan antes para el usuario doméstico que en entornos empresariales. Tecnologías disruptivas que podrían replantearlo todo Más allá de la guerra NAND vs magnética, existen alternativas emergentes con potencial disruptivo a medio-largo plazo: Las amenazas de los HDD serían las caídas bruscas del coste de la memoria NAND, que no se espera por el momento, o problemas para seguir aumentando la capacidad de las unidades HDD, e incluso la llegada de avances de otras memorias que puedan sustituir a las actuales unidades. 2030 = Disco duro combinado con SSD La arquitectura dominante en 2030 tenderá a ser multi-tier y jerarquizada, donde se convinarán unidades más veloces como los SSD NVMe/Tier-0 para IA y bases críticas, otras unidades flash para hot datasets, y HDD (o alternativas de alta densidad) para nearline/archivo a gran escala. También me gustaría destacar tecnologías de software como almacenamiento por zonas (Zoned Namespaces o ZNS) y políticas inteligentes de datos permitirán explotar al máximo cada medio y reducir coste total…

CL28 vs CL36 en DDR5 ¿La latencia importa para jugar?

La diferencia entre módulos CL28 y CL36 se ha convertido en un tema de debate entre entusiastas del rendimiento, como los gamers. ¿Influye realmente en los FPS o en la fluidez de tus partidas? ¿Vale la pena pagar más por menores tiempos de respuesta? Cuando hablamos de memoria RAM DDR5, los números no son solo decoración técnica o marketing de los fabricantes. Una de las cifras más importantes en las que nos debemos fijar, además de en la frecuencia y la capacidad, es en la latencia. ¿Qué es la latencia CAS (CL)? La latencia CAS (Column Address Strobe), conocida también como CL, representa el número de ciclos de reloj que tarda un módulo de memoria RAM en responder a una solicitud de lectura desde una columna específica una vez que se ha accedido correctamente a la fila correspondiente. En términos prácticos, CL indica el tiempo de espera entre que el controlador de memoria solicita un dato y la RAM comienza a entregarlo. Por ejemplo, si una memoria tiene una CL36, esto significa que el controlador debe esperar 36 ciclos de reloj desde que se hace la solicitud hasta que los datos empiezan a fluir. ¿Cómo se calcula la latencia real en nanosegundos? Aunque los valores de CL (como CL28, CL36, CL40…) son útiles como referencia relativa, lo que realmente importa es la latencia en tiempo real, medida en nanosegundos (ns). Esta depende tanto del número de ciclos de reloj (CL) como de la frecuencia de la memoria. La fórmula es: Latencia real (ns) = (CL × 2000) / Frecuencia efectiva (MT/s) La frecuencia efectiva de DDR (Double Data Rate) es el doble de la frecuencia de reloj real del módulo. Por ejemplo, 6000 MT/s implica 3000 MHz reales. Esto nos deja ejemplos prácticos como: A pesar de tener un número CL mayor, la latencia real de una DDR5 no tiene por que ser peor. De hecho, a pesar del salto de latencias de la DDR4 a DDR5, merece la pena usar una DDR5 debido a las mejoras de esta nueva generación y el mayor ancho de banda que aporta. ¿Por qué la DDR5 tiene valores CL más altos que DDR4? Desde un punto de vista técnico, la DDR5 introduce una serie de cambios estructurales en comparación con DDR4, lo que explica el incremento en el número de ciclos de latencia aparente: Pero, vuelvo a repetir, esto no significa que la DDR5 sea peor que la DDR4, ya que ha mejorado otras muchas cosas que dan un impulso significativo al rendimiento global. CL28 vs CL36 en gaming: ¿Importa realmente? Una vez dicho esto, veamos si dentro de la DDR5 es importante elegir módulos CL28 frente a CL36 para gaming o no es tan vital cono parece. Para ello, vamos a tomar como referencia tres módulos de memoria RAM idénticos para nuestros cálculos, concretamente unos de DDR5-6000: Supongamos que los tres kits tienen una capacidad de 32 GB en total, y como he dicho son 6000 MT/s. Y también hay que suponer que se hacen las pruebas con el mismo hardware base, misma CPU y GPU. Por ejemplo, una plataforma de pruebas con un Ryzen 9 9800X3D y una RTX 4090, ejecutando juegos exigentes como F1 2024 y Black Myth: Wukong a resoluciones de 1080p, 1440p y 4K. El término tRCD significa RAS to CAS Delay o más correctamente Row Address Strobe to Column Address Strobe Delay. Y es importante explicarlo antes de seguir con nuestro experimento. Cuando la RAM quiere acceder a un dato, debe hacer lo siguiente: El TRCD define cuántos ciclos de reloj deben pasar entre estos dos pasos para que la CPU pueda acceder al dato almacenado en la RAM. Dicho de otra forma, es el tiempo que tarda la memoria en cambiar del acceso a una fila al acceso a una columna dentro de esa misma fila. Por ejemplo, imagina que la RAM está organizada como una tabla (filas y columnas). Latencia real (ns) = (TRCD × 2000) / Frecuencia efectiva (MT/s) Ejemplos: Ahora que ya sabes su significado, volviendo a los ejemplos anteriores, vemos que se usan configuraciones de TRCD 48 y TRCD 36 para los módulos, lo que significa que necesitan 48 y 36 ciclos de reloj entre RAS y CAS respectivamente, lo que hace a la segunda más rápida. Es decir, igual que en el caso de CL, un número inferior siempre significa que es más rápida… No obstante, en teoría, el tRCD no tiene un impacto tan grande en el rendimiento general como lo tiene el CL. Analizando los datos obtenidos en este experimento, tenemos que: Pese a lo que muchos piensan, optar por un CL28 o un CL36 apenas afecta al gaming, con diferencias menores al 1-2% en la mayoría de las condiciones reales. Sin embargo, esto dependerá del videojuego usado. Por ejemplo, algunos juegos de mundo abierto o que dependen mucho de los datos de CPU para la gestión de datos en tiempo real, como pueden ser Flight Simulator, Civilization o StarCraft II, una menor latencia puede ayudar, no tanto en un aumento significativo en los FPS, como sí en la estabilidad del framerate durante el juego. En videojuegos muy dependientes de la GPU, o con tasas de FPS muy elevadas, el impacto del CL menor es mínimo, por lo que te podrías ahorrar unos euros si solo vas a jugar a estos juegos… Ten en cuenta que puede haber diferencias de más de 40€ en algunos kits que pasan de CL36 a CL28. Entonces… ¿Qué memoria debo comprar? La latencia CAS (CL) es un parámetro clave en la percepción del rendimiento de la memoria, pero no se debe analizar de forma aislada. En gaming, el impacto de bajar de CL36 a CL28 es mínimo y depende fuertemente del título, la resolución y la carga de CPU. En general, optimizar el TRCD y mantener una buena frecuencia DDR5 ofrece mayor ganancia que enfocarse únicamente en la latencia CAS más baja posible. Así que, si no te importa invertir un poco más para obtener el mejor resultado, CL28/tRCD36 es la mejor opción. Para los que buscan la mejor

SSD NVMe Gen5 vs Gen4 ¿Compensa la diferencia económica?

La batalla entre los SSD NVMe Gen5 y Gen4 está en pleno auge, y no es solo una cuestión de números: es una evolución que redefine el rendimiento, la eficiencia y el futuro del almacenamiento en PC. Pero… ¿realmente un usuario siente esa mejoría en la experiencia? En este artículo exploraremos las diferencias clave entre ambas generaciones, desde velocidades de lectura y escritura hasta compatibilidad, disipación térmica y beneficios reales en tareas cotidianas como gaming, edición de video o carga de sistemas operativos. Características técnicas: Gen4 vs Gen5 La siguiente tabla resume las principales diferencias entre ambas generaciones de SSD NVMe: Característica ssd NVMe PCIE Gen4 SSD NVMe PCIE Gen5 Ancho de banda por carril ~2 GB/s ~4 GB/s Ancho de banda total x4 ~8 GB/s ~16 GB/s Velocidades típicas de lectura secuencial 5.000 – 7.500 MB/s 9.000 – 14.000 MB/s Latencia ~60 – 80 µs ~50 – 70 µs Consumo energético Moderado Alto (mayor temperatura, necesidad de disipador) Precio en 2025 Más accesible Más caro (de un 25% a un 50% con igual capacidad) ¿Se aprovecha realmente PCIe Gen5 en el caso de las unidades SSD NVMe actuales? Aunque los benchmarks sintéticos muestran un salto espectacular en lectura y escritura secuencial, la realidad es que no todos los escenarios saturan Gen4. La mayoría de las aplicaciones de oficina, gaming y uso general no requieren más de 3-5 GB/s sostenidos, valores que Gen4 ofrece sin dificultad. Donde Gen5 muestra ventaja real es en transferencias de archivos masivos (edición de video 8K, datasets científicos, backups de varios terabytes) y en entornos profesionales donde la simultaneidad de accesos es constante. También en cargas de trabajo con IA, bases de datos de gran volumen y servidores de contenido, la menor latencia y el mayor ancho de banda son determinantes. Es decir, si quieres una unidad SSD para ofimática, streaming, edición de fotos, y gaming, la opción Gen4 es suficiente, y el ahorro para tu configuración será importante. Además, no tendrás que cambiar a una placa base que soporte PCIe Gen5 para unidades de este tipo. Solo en casos extremos, como entornos profesionales, o de muy alto rendimiento, merece la pena saltar a Gen 5, hoy por hoy… Diferencias reales para el usuario La principal diferencia práctica está en los tiempos de transferencia. Copiar un archivo de 100 GB en un SSD Gen4 de gama alta puede tardar unos 20 segundos, mientras que en un Gen5 se reduce a la mitad o menos. En cargas de trabajo con millones de IOPS, Gen5 también puede reducir colas y mejorar la respuesta. Otro aspecto a considerar es la temperatura. Muchos SSD Gen5 requieren disipadores voluminosos o incluso ventiladores activos, lo que puede ser un factor en sistemas compactos o silenciosos, como los ultrabooks, miniPCs, etc.

Cómo mejorar el rendimiento de tu portátil ampliándolo con memoria RAM SODIMM

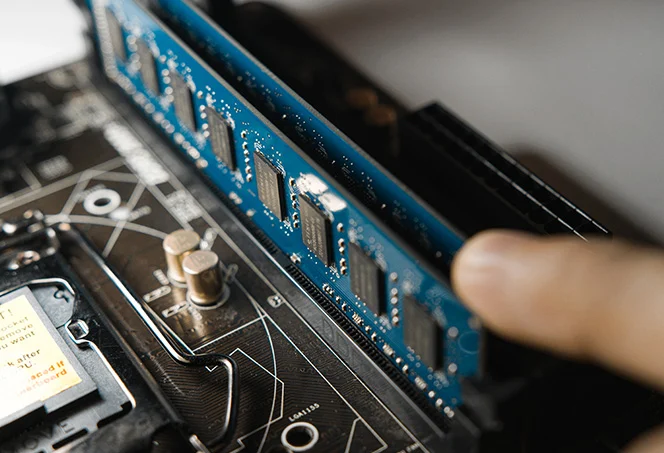

¿Cuánta memoria RAM necesita mi portátil? Uno de los componentes imprescindibles de un ordenador, ya sea sobremesa o portátil, es la memoria RAM o memoria de acceso aleatoria (Random Access Memory) donde se almacenan los datos que procesa la CPU directamente. De su velocidad y capacidad depende parte del rendimiento general del ordenador, por lo que tener la capacidad de memoria necesaria para el uso que le damos al PC es algo muy importante para poder exprimirlo al máximo y evitar problemas de rendimiento. Hoy en día, tenemos portátiles a la venta con distintas capacidades de memorias, desde modelos básicos con 4 GB de memoria RAM, hasta modelos de alto rendimiento con 32, 64 o incluso más GB. Pero ¿Cuánta memoria RAM necesita mi portátil? La respuesta a esta pregunta depende de varios factores, pero el principal es el uso que le vayamos a dar al ordenador. Por lo general, si queremos conseguir el máximo rendimiento en tareas de todo tipo, 16GB de memoria es una cantidad óptima para la gran mayoría. Incluso en portátiles que no vayan a realizar tareas intensivas, 8 GB podría ser una capacidad suficiente. Capacidades inferiores penalizan en exceso el rendimiento del sistema, y capacidades superiores de 32 GB o más se orientan ya a máquinas de alto rendimiento que necesitan ejecutar tareas con una demanda muy alta de memoria. En la mayoría de ordenadores es posible sustituir o cambiar la memoria RAM de manera bastante sencilla, esto incluye a gran parte de los ordenadores portátiles que cuentan con su propio formato SO-DIMM. Naturalmente, hay que tener en cuenta el tipo de memoria que soporta el portátil para sustituirla. En la actualidad, la gran mayoría de portátiles con memorias en formato SO-DIMM utilizan módulos DDR4. Adicionalmente, disponer de Dual Channel también nos permite aumentar algo más el rendimiento al poder acceder de manera simultánea a dos módulos de RAM. Para ello es necesario tener, al menos, dos módulos de memoria a la vez y con especificaciones simlares. En esta guía os vamos a enseñar ampliar la memoria RAM del portátil para mejorar su rendimiento con memorias IRDM DDR4 de GoodRAM en formato SO-DIMM Equipo de pruebas El portátil que vamos a utilizar como base para la guía es el HP Pavilion x360 14-dh1011ns, un modelo convertible de 14 pulgadas con resolución FullHD y pantalla táctil que se basa en un procesador Intel Core i3-10110U de décima generación y un SSD de 128 GB. Este portátil es un candidato perfecto para mostrar las mejoras de rendimiento que se consiguen al ampliar la memoria RAM porque cuenta con tan solo 4 GB de memoria RAM DDR4-2666 MHz, una cantidad muy baja que lastra su desempeño a costa de reducir su precio. Además, hay que tener en cuenta que, en muchos casos, suele salir más caro adquirir una versión de un portátil que venga con más cantidad de memoria, que comprarlo con poca memoria y ampliarla posteriormente. Este equipo cuenta con dos slots SO-DIMM, por lo que es posible sustituir o añadir más memoria RAM. Características técnicas HP Pavilion x360 14-dh1011ns Memorias RAM SO-DIMM GoodRAM IRDM DDR4 Para ampliar la memoria del portátil vamos a utilizar las memorias RAM IRDM DDR4 de GoodRAM en formato SO-DIMM. En concreto, tenemos dos módulos de 8 GB cada uno, es decir, 16 GB de memoria RAM. El diseño de estos módulos está marcado por sus dos disipadores metálicos en color negro con el logo de IRDM destacado en rojo. Tienen el formato estándar SO-DIMM utilizado en la práctica totalidad de portátiles y también otros dispositivos como mini-PCs. En este caso, las velocidades de funcionamiento máximo de las IRDM DDR4 de GoodRAM con perfiles XMP son de 2.666 MHz con unas latencias CL16-18-18, adicionalmente cuenta con perfiles estándar JEDEC con velocidades de hasta 2134 MHz con latencias CL14-14-14, otro perfil CL15 y otro CL16. El tema de los perfiles JEDEC y XMP es importante mencionarlo porque, por lo general, los portátiles convencionales no cuentan con soporte para perfiles XMP, salvo aquellos gaming avanzados o configuraciones específicas para entusiastas. Los perfiles que siguen el estándar DDR4 son los JEDEC, mientas que los XMP suponen un aumento de las frecuencias o disminución de latencias mediante «overclock». Esto significa que si colocamos unos módulos en un portátil como el HP que estamos utilizando como ejemplo, no podremos configurar la velocidad de la memoria y esta funcionará con el perfil estándar JEDEC más rápido, dejando fuera a los perfiles XMP. En el caso de estos módulos en este portátil, tenemos que la velocidad máxima de funcionamiento será de 2134 MHz con latencias CL14. Características técnicas de las memorias SO-DIMM GoodRAM IRDM DDR4 Cómo ampliar la memoria RAM del portátil paso a paso Una vez tenemos claro qué tipo de memorias RAM utiliza nuestro portátil y si dispone de slots SO-DIMM para cambiar o ampliar la memoria, deberemos proceder a desmontar el equipo para poder acceder a dichos módulos. Existen cientos de modelos de portátil diferente con un montón de maneras de acceder al interior, hay modelos donde el acceso a los módulos de RAM es tan sencillo como retirar la tapa trasera, y otros que requieren de desmontar más componentes, incluyendo el teclado o la propia placa base del equipo. Hoy en día, en la mayoría de portátiles que permiten la ampliación o sustitución de la memoria, acceder a los módulos suele requerir únicamente retirar la tapa trasera. En el portátil que hemos utilizado para esta guía, el HP Pavilion X360 de 14 pulgadas, en concreto el modelo dh1011ns, deberemos retirar la tapa trasera mediante cuatro tornillos. Hay otros portátiles que requieren de más o menos tornillos, eso ya dependerá del fabricante y el modelo. Igualmente, el cabezal del tornillo depende del modelo y el fabricante, habiendo portátiles que necesitan destornilladores TORX y otros que utilizan cabezales normales. Generalmente, dichos tornillos son visibles desde el exterior, pero hay otros, como es el caso de este HP, donde algunos de los tornillos están ocultos tras pegatinas o las propias peanas de apoyo. Tenemos dos tornillos de visibles en la parte inferior, uno en cada extremo. Los otros dos tornillos están situados bajo los dos apoyos de goma de la parte más alta, por lo que es necesario retirarlos.

Hacer particiones a un SSD, ¿afecta a su rendimiento?

Muchos son los fabricantes de portátil que venden sus equipos con una copia de respaldo del sistema operativo para recuperar en caso de que el equipo no funcione como el primer día. Esta copia de respaldo permite recuperar el equipo a su estado de fábrica sin tener que instalar Windows de cero y no se encuentra en la unidad principal, sino en una partición independiente. Al comprar un portátil o un PC de escritorio con discos SSD ya instalados, a menudo damos por sentado que todo está listo para que lo usemos según los saquemos de la caja y que el almacenamiento nos va a servir en una única unidad. Sin embargo, muchos fabricantes optan por añadir a sus modelos de discos sólidos particiones oculta, pero accesibles, que cumplen con funciones especialmente útiles, como son las de restaurar el sistema operativo a su estado original en caso de error. Esto plantea, como es lógico, una duda muy recurrente entre los usuarios: ¿afecta todo ese particionado a la velocidad o durabilidad del SSD que hemos comprado con el PC? ¿Es recomendable dividir en varias particiones una unidad de estado sólido como hacíamos con los antiguos discos duros mecánicos? Cuando hablamos de particiones, hablamos de partes de un disco duro de menor tamaño que en su conjunto ocupan el espacio total de la unidad de almacenamiento. Para el equipo, se trata de unidades independientes, por lo que cada una puede tener su propio sistema de archivos lo que permite instalar diferentes sistemas operativos. Es importante señalar que estamos hablando de un único disco duro o SSD, por lo que, si este se estropea o tiene problemas de funcionamiento, estos problemas pueden afectar a ambas unidades. Este artículo, por todo lo anterior, pretende aclarar todas estas dudas de una forma sencilla. Por eso vamos a explorar y conocer qué es exactamente una partición, cómo funciona en una unidad SSD y qué implicaciones reales tiene su uso –dividido en varias unidades– en cuanto a rendimiento se refiere. Además, te vamos a explicar lo más importante: si merece la pena aplicar esta técnica dentro de distintos escenarios, como es el caso de un PC de sobremesa o un portátil. Particionar un SSD ¿afecta a su rendimiento? Todo esto está muy bien, pero ¿qué pasa con el rendimiento? Esta es la pregunta que se hacen muchos usuarios y que en HardZone vamos a responder. Las unidades de estado sólido, a diferencia de los discos duros, almacenan la información los datos en chips de memoria, por lo que el acceso a la información es inmediato. Los discos duros mecánicos, utilizan un disco para almacenar los datos, datos leídos por un cabezal que se tiene que desplazar para acceder a ellos. Si particionamos un disco duro tradicional, cada vez que tengamos que acceder a cualquiera de las unidades, el equipo tardará mucho más tiempo, ya que tiene que desplazar el cabezal entre ambas particiones. Como los SSD almacenan los datos de forma digital, toda la información está al mismo alcance, no hay un cabezal que tenga que desplazarse para acceder a los datos, por lo que su rendimiento, tanto a la hora de leer como de escribir datos, no se ve afectada si creamos particiones. Esto también afecta a otros aspectos que podemos encontrar en el sistema operativo que están diseñados para optimizar las capacidades que tiene una unidad de almacenamiento tradicional como son los HDD. Uno de los mejores ejemplos que encontramos en este caso es la desfragmentación del disco, en un disco duro tradicional los sectores podían crear espacios que dejaban inutilizables en varias ocasiones la capacidad del mismo, esto se le conoce como fragmentación y hace referencia a cómo asigna el sistema operativo la capacidad para cada programa. Esta función en los SSD es completamente inútil ya que al no tener sectores físicos es capaz de asignar los datos según lo vea necesario, de forma que no ofrece ningún tipo de ventaja (ni desventaja) al utilizar el PC, tal y como sucede con el particionado de la unidad. Qué herramientas se puede utilizar para particionar un SSD de forma segura Una vez tenemos claro que crear particiones adicionales en un SSD no afecta en ningún momento a su rendimiento, si estás dándole vueltas a la posibilidad de hacerlas, debemos tener en cuenta, en primer, hacer una copia de seguridad de todos los datos que tenemos almacenados en su interior por si, el proceso falla no perder todos los datos sin posibilidad de recuperación. También es recomendable analizar el estado del SSD utilizando la aplicación CystalDiskInfo (disponible desde aquí) y asegurarnos de que el TRIM está activado en el equipo para ayudar al SSD a gestionar recopilar la basura manteniendo la velocidad. Una vez hemos realizado estos procesos, a continuación, os mostramos las mejores aplicaciones para crear particiones en un SSD. ¿Merece la pena? El precio de los SSD en los últimos años ha bajado considerablemente y encontrar un modelo con 512 GB o 1 TB de espacio de almacenamiento por unos 50 o 60 euros, es muy sencillo. Con estos precios, realmente no merece la pena particionar un SSD, siempre y cuando estemos hablando de un equipo de sobremesa donde podemos añadir varias unidades de almacenamiento. Pero, si hablamos de un portátil la cosa cambia, a no ser que si permita añadir una segunda unidad de almacenamiento. Lamentablemente, no todos los portátiles permiten añadir una segunda unidad de almacenamiento por lo que, en estos casos, si merece la pena crear una partición, aunque no tengamos la intención de instalar una distribución de Linux. Podemos particionar el disco para utilizar la segunda unidad para almacenar todos y cada uno de los archivos con los que trabajemos habitualmente. De esta forma, podemos utilizar una aplicación para hacer copias de seguridad de toda la unidad, sin tener que establecer directorios y que se nos pase alguno. Además, si Windows tiene algún problema y nos vemos obligados a formatear e instalarlo de cero, no es necesario hacer una copia de seguridad de todos los datos, ya que

Cómo saber cuántas horas de uso tiene tu disco duro o SSD

El disco duro o SSD es uno de los componentes más importantes de cualquier PC, ya que es el que se utiliza para encender el ordenador y, sobre todo, almacenar toda la información. Si el disco duro o SSD deja de funcionar, y no hemos tenido la precaución de hacer una copia de seguridad periódica o utilizar una plataforma de almacenamiento en la nube como respaldo, tenemos un serio problema muy difícil de resolver. Cuando hablamos de un problema con el disco duro, no nos referimos un problema con una partición o con los sectores de arranque que se pueden solucionar fácilmente sin formatear. Nos estamos refiriendo a un problema de funcionamiento, que la unidad no sea capaz de leer correctamente los datos almacenados en su interior debido a que ha cumplido su ciclo de vida útil. Todos los discos duros, al igual que las unidades SSD, incorporan un contador en interior que se encarga de registrar el número de veces que se ha encendido, el número lecturas y escrituras además del número de horas que ha estado en funcionamiento. En base a estos datos, podemos hacernos una idea de cuánta vida útil le puede quedar de vida. ¿Durante cuantas horas se ha utilizado un disco duro? Si tenemos alguna duda acerca del funcionamiento de nuestro disco duro, desde Windows, lo único que podemos saber es si se encuentra en buen estado utilizando CMD con el siguiente comando: wmic diskdrive get status Este comando nos devolverá un OK tantas veces como unidades tengamos instaladas y en el orden que siguen C:, D:, F:… Lamentablemente, Windows no nos muestra cuál es el número de horas que tiene registradas la unidad de almacenamiento de nuestro PC, por lo que, una vez más, nos vemos obligados a recurrir a aplicaciones de terceros, siendo CrystalDiskInfo la opción más recomendable. CrystalDiskInfo CrystalDiskInfo es una aplicación gratuita que no solo nos muestra el número de horas que hemos utilizado el disco duro o SSD. También nos muestra el estado en el que se encuentra a través de códigos de colores: Para calcular la salud del disco duro utiliza el número de lecturas y escrituras de host, el número de encendidos y horas en funcionamiento entre otros, de ahí que no exista una referencia que indique un número de horas concreto en el que un disco duro o SSD deje de funcionar. La descarga de esta aplicación es completamente gratuita y la única forma de hacerlo para estar seguros de que la aplicación no incluye ningún tipo de software malicioso es a través de su página web, a la que podemos acceder desde aquí. Desde HardZone os recomendamos descargar la aplicación portable disponible en formato .zip. Una vez la hemos descargado, descomprimimos el archivo y ejecutamos el archivo correspondiente a nuestra versión de Windows: DisInfo32.exe para Windows de 32 bits (Windows 10 y versiones anteriores) o DiskInfo64.exe para Windows 11 en adelante (esta versión de Windows solo está disponible para procesadores de 64 bits). Una vez hemos abierto la aplicación, el número de horas de uso se muestra en la parte superior, en el artado Horas encendido tal y como podéis ver en la siguiente imagen. Hard Disk Sentinel Si bien es cierto que CrystalDiskInfo es una de las aplicaciones más populares y utilizadas para medir el número de horas de funcionamiento de un disco duro, no es la única aplicación que permite conocer esta información. Hard Disk Sentinel es una más que interesante alternativa que también nos permite conocer esta información. Con Hard Disk Sentinel, además, también podemos realizar una supervisión avanzada del estado y funcionamiento del disco duro o SSD, predecir posibles fallos para así evitar perder los datos almacenados, reparar errores, registra un histórico de las temperaturas y mucho más. Para conocer el número de horas de funcionamiento de un disco duro, con la versión gratuita es más que suficiente, versión que podemos descargar directamente desde su página web a través de este enlace. ¿Cuántas horas dura un disco duro? Los discos duros, especialmente los destinados a dispositivos NAS y servidores, están diseñados para durar incluso 50.000 horas sin problemas, mientras que los discos duros tradicionales empiezan a fallar más 25.000 horas de uso. Es importante señalar que, cuando un disco duro se considera en funcionamiento cuando se están leyendo o escribiendo datos, no solo por el simple hecho de estar conectado a un PC. Cuando un disco duro no se utiliza, los cabezales se retiran del disco hasta que haga falta, de ahí el tiempo inicial que tardan estos en empezar a funcionar cuando accedemos a una unidad del equipo con un disco duro. Sin embargo, eso no significa que estos puedan dejar de funcionar antes de esa cifra. La durabilidad de un disco duro no solo depende de los elementos y componentes que se han utilizado durante su fabricación, sino también la calidad de los mismos y, sobre todo, el entorno de donde se encuentra. Un disco duro o cualquier otro dispositivo electrónico, no funcionará de igual forma si se encuentra en entornos húmedos o demasiado calurosos.

¿Sabías que se puede utilizar la RAM como dispositivo de almacenamiento?

Para muchas personas que buscan tener un ordenador centrado en la productividad resulta extremadamente necesario conseguir la mayor velocidad posible a la hora de transferir archivos, pero para ello hay que invertir mucho dinero, siempre y cuando queráis que esos datos se guarden, ya que para conseguir velocidad hay otra forma de guardarlos hasta que el PC se apague, usando la RAM como dispositivo de almacenamiento. Una de las grandes ventajas que tiene la memoria RAM es la velocidad que ofrece, motivo por el que se utiliza como intermediario que permite almacenar de forma provisional los programas que hay guardados en un SSD o disco duro y el procesador mientras se utilizan. Y aunque no lo parezca hay una forma de forzar que el propio PC pueda reconocer el espacio dedicado a la memoria RAM como una unidad de almacenamiento de alta velocidad que puede llegar a servir para transferir datos de la forma más rápida posible, algo que no utilizaríamos en un ordenador para jugar o para navegar pero que en uno que está diseñado para productividad puede ser realmente útil. Así puedes utilizar tu memoria RAM para guardar datos de forma provisional La memoria RAM como bien sabemos es un tipo de almacenamiento provisional, es completamente volátil por lo que cuando el ordenador se apaga prácticamente todos los datos que hay guardados en la misma se borran. Este es el principal motivo por el que no se utilizan para guardar datos de forma persistente ya que realmente existen formas de montarla como si fuese un disco normal y corriente que el ordenador puede reconocer, y seguramente las velocidades que puede llegar a alcanzar os sorprenderán. Para poder utilizar el espacio libre que tenéis en esta memoria como dispositivo de almacenamiento necesitaréis un programa llamado PassMark OSFMount, a continuación os explicamos cómo utilizarlo: Cuando hayáis terminado de hacer esta configuración os aparecerá en el propio programa la unidad de almacenamiento con la letra asignada, el tipo, el tamaño, las propiedades y los diversos sistemas de archivos detectados. Con esto ya tendréis listo el espacio que hayáis asignado para utilizarlo como forma de guardar datos de manera provisional, si accedéis al explorador de tareas podréis ver cómo el propio sistema lo detecta lo que os permitirá interactuar con él. Como podéis imaginar esto pondrá una carga sobre vuestra memoria RAM que podréis consultar en el administrador de tareas, en este simplemente tendréis que buscar el proceso «System» que será el que está consumiendo este espacio para alojarlo como método de almacenamiento. Para que podáis ver la diferencia de velocidades que tiene en comparación con una unidad SSD M.2 hemos hecho una serie de pruebas, la memoria RAM es una Corsair Vengeance DDR5 de 16×2 GB con una configuración de 6000 MHz mientras que la unidad de almacenamiento con la que la hemos comparado es SSD M.2 PCIe 4.0 Corsair MP600 Pro NH. La diferencia de velocidad es impresionante, la memoria RAM es capaz de superar incluso a las unidades de almacenamiento PCIe Gen 5 con facilidad pero obviamente no es persistente como hemos repetido en varias ocasiones, lo que hace que no se pueda utilizar en ámbitos que involucren tener que guardar los datos tras apagar el PC. ¿Tiene esto algún tipo de funcionalidad real? Uno de los principales motivos por los que se han desarrollado interfaces superiores a SATA tiene que ver con la velocidad que pueden llegar a alcanzar. Está claro que en un ordenador normal o gaming optar por un SSD PCIe 4.0 que tenga velocidades entre 5.000-7.500 MB/s es más que suficiente, ya que los modelos PCIe 5.0 que pueden ofrecer hasta 15.000 MB/s no son necesarios. Esto implica que no existe un motivo real para utilizar la memoria RAM como almacenamiento en un ámbito normal, pero si que podemos encontrar mejoras a la hora de trabajar con archivos grandes. Esto podemos aplicarlo por ejemplo a las workstation u ordenadores utilizados para tareas pesadas con archivos temporales como la edición de vídeo, al ser más rápida mejora en gran medida el rendimiento ya que tarda menos en acceder a los datos, pero el problema está en que a su vez también limita el máximo de RAM disponible, algo que puede resultar contraproducente.

Windows 11 vuelve a fallar: la última actualización da problemas con algunos SSD

Las actualizaciones de Windows 11 siguen dándole quebraderos de cabeza tanto a usuarios como fabricantes. En esta ocasión, el problema es bastante grave ya que la actualización KB5063878 incluida en la versión 24H2, build 26100.4946 está provocando fallos críticos en unidades SSD con controladora Phison. En seguida te contamos cuál es el problema y cómo saber si tu SSD estaría afectado, pero por ahora la recomendación es evitar instalar esta actualización hasta que Microsoft confirme una solución. Varios usuarios están reportando que, tras instalar esta actualización de Windows, sus unidades dejan de ser reconocidas en el sistema operativo tras realizar tareas de escritura intensiva (mover o copiar archivos de gran tamaño, por ejemplo), y la unidad se vuelve inaccesible al reiniciar el PC. Es fundamental señalar que, a fecha de publicación de este artículo (18/08/2025), ni Microsoft en su panel de salud de Windows ni Phison Electronics han emitido comunicados oficiales reconociendo este problema. La alerta inicial proviene de reportes de la comunidad, destacando la investigación del usuario @Necoru_cat en X, quien ha correlacionado la actualización KB5063878 con fallos en SSDs que utilizan controladoras Phison. HardZone ha contactado a ambas compañías para obtener una declaración oficial y actualizará este artículo en consecuencia. Cómo saber si tu SSD podría estar afectado Según los reportes iniciales, el fallo no se limita a un modelo en concreto sino que parece estar relacionado con la gestión de las controladoras Phison bajo determinadas condiciones. Entre las unidades mencionadas por los usuarios se encuentran por ejemplo los Corsair Force MP600, SanDisk Extreme Pro o Kioxia Exceria Plus G4 entre otras. El denominador común en todas las unidades es, como decíamos, la controladora Phison. Marca Modelo Controladora Phison Corsair Force MP600 PS5016-E16 SanDisk Extreme Pro M.2 PS5016-E16 (Triton MP28) Kioxia Exceria Plus G4 PS5027-E31T Sabrent Rocket 4 Plus PS5018-E18 Kingston NV2 PS5021-E21T PNY CS3030 PS5012-E12 Fikwot FN955 No especificado A pesar de que no todos los SSD con controladora Phison parecen estar afectados por el problema, la recomendación por el momento es que si tu SSD la tiene, no instales esta actualización de Windows por precaución. Ahora, contestando a la pregunta, ¿cómo puedes saber si tu SSD tiene controladora Phison? Hay varias formas de saberlo: Cuando tengas ya claro qué controladora utiliza tu SSD, la premisa es que si ésta es Phison, tu SSD podría estar afectado y lo mejor es que no actualices Windows 11 por el momento. Si es de otro fabricante, no deberías tener ningún problema que se sepa. Qué hacer si ya tienes Windows 11 24H2 instalado Como decíamos, Microsoft por ahora no ha reconocido el problema, así que mientras lo hacen y lo analizan para lanzar una solución, la recomendación es que si ya tienes esta actualización instalada evites operaciones de escritura masiva en el SSD, es decir, que no te pongas a copiar archivos grandes sobre todo. Esto incluye copias de seguridad, movimientos de carpetas multimedia o incluso instalación de juegos de gran tamaño. En el caso de que sea imprescindible realizar transferencias de datos, lo más prudente sería recurrir a una unidad secundaria o almacenamiento en la nube para minimizar los riesgos. el mismo modo, sería recomendable mantener al menos una copia de los datos importantes de tu SSD, es decir, intenta hacer una copia de seguridad a otra unidad que no esté afectada (recuerda, el problema afecta al escribir datos en la unidad, así que no debería pasar nada por leer grandes cantidades de datos para copiar las a otra).