Cómo clonar tu disco a NVMe sin reinstalar Windows (paso a paso seguro)

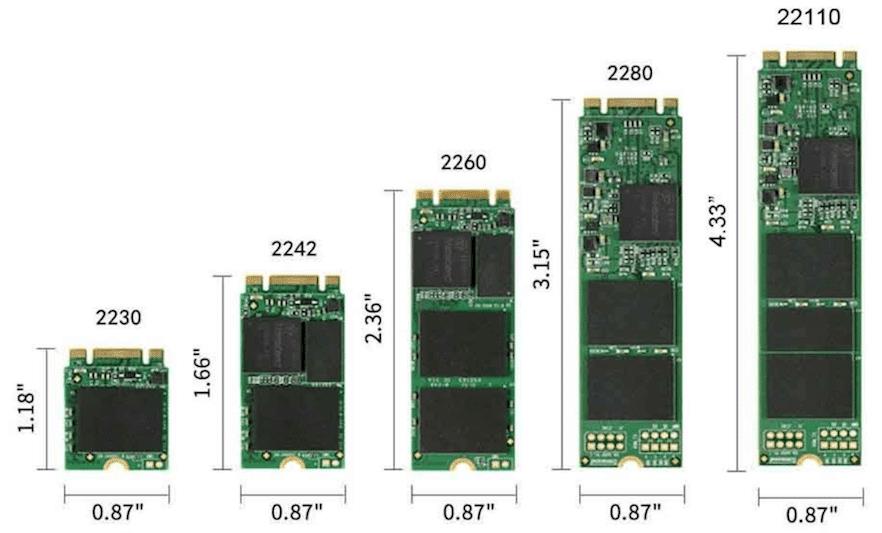

Dar el salto a una unidad NVMe es una de esas mejoras que se notan desde el primer arranque: más velocidad, menos latencia y un sistema que responde al instante. Si ya tienes tu PC funcionando, lo lógico es querer migrarlo tal cual sin reinstalar Windows ni tus aplicaciones. La buena noticia es que puedes clonar tu disco a NVMe y arrancar como si nada.Y sin tener que reinstalar el sistema. En esta guía reunimos todo lo imprescindible para lograrlo con total seguridad: qué es NVMe y por qué importa, requisitos y preparativos, herramientas recomendadas y pasos precisos para clonar. Además, te dejamos trucos para evitar sustos y cómo configurar el arranque del nuevo disco en la BIOS/UEFI. NVMe en pocas palabras: por qué es tan rápido y cómo se conecta NVMe (NVM Express) es una especificación creada específicamente para SSD que usan PCI Express, con un objetivo claro: exprimir la paralelización y el ancho de banda del bus PCIe. A diferencia de los SSD tradicionales, NVMe admite colas de hasta 64.000 comandos, y el propio protocolo funciona con tan solo trece comandos bien optimizados para ser eficiente. Mientras que en unidades más antiguas se procesa una operación tras otra, NVMe permite trabajar con muchísimas operaciones en paralelo, lo que reduce cuellos de botella y latencias. El resultado se nota al abrir programas, mover archivos grandes o cargar juegos: todo va considerablemente más rápido. En cuanto a formatos, verás NVMe en M.2 (el más habitual en portátiles y sobremesa modernos), tarjetas PCIe y en U.2. U.2 es un factor de forma que utiliza exclusivamente el protocolo NVMe, pensado para chasis y entornos que necesitan unidades hot-swap o cables en lugar del módulo M.2. La conexión NVMe se realiza directamente sobre PCIe, por eso su rendimiento es tan alto frente a SATA. En resumen, conectividad, velocidad y eficiencia son el terreno natural de NVMe, y por eso es la opción ideal para tu disco del sistema. ¿Puedo clonar un NVMe a otro NVMe (o desde SATA a NVMe)? La respuesta corta es sí: puedes clonar un SSD NVMe a otro NVMe, y también migrar desde un HDD/SSD SATA a un NVMe. Mucha gente lo hace para ganar capacidad sin perder su instalación de Windows ni sus programas, o para acelerar un equipo que aún usa un disco mecánico. Windows no incluye una función de clonación de discos integrada, así que necesitarás software de terceros. La ventaja es que estas herramientas han pulido mucho el proceso: no hace falta reinstalar el sistema y, si haces las cosas bien, tus datos permanecen a salvo durante toda la migración. En esencia, clonar es copiar a nivel de disco o partición todo el contenido del origen al destino, de forma que el equipo arranque desde la nueva unidad como si siempre hubiera estado ahí. Este proceso funciona igual si pasas de HDD a NVMe, de SATA a NVMe o de NVMe a NVMe. Windows no incluye una función de clonación de discos integrada, así que necesitarás software de terceros. La ventaja es que estas herramientas han pulido mucho el proceso: no hace falta reinstalar el sistema y, si haces las cosas bien, tus datos permanecen a salvo durante toda la migración. En esencia, clonar es copiar a nivel de disco o partición todo el contenido del origen al destino, de forma que el equipo arranque desde la nueva unidad como si siempre hubiera estado ahí. Este proceso funciona igual si pasas de HDD a NVMe, de SATA a NVMe o de NVMe a NVMe. Herramientas de clonación recomendadas y qué ofrece cada una Existen muchas aplicaciones válidas, pero hay tres que destacan por su equilibrio entre facilidad, funciones y tasa de éxito: EaseUS Disk Copy, Wondershare UBackit y AOMEI Partition Assistant Professional. EaseUS Disk Copy EaseUS Disk Copy destaca por una interfaz clara y muy directa. Aunque Windows no traiga clonador nativo, con esta herramienta podrás replicar tu disco sin reinstalar nada. El flujo es sencillo: eliges modo de clonación (p. ej., Modo de disco), seleccionas el disco de origen, el destino y eliges cómo quieres distribuir las particiones en el nuevo NVMe. Herramientas de clonación recomendadas y qué ofrece cada una Existen muchas aplicaciones válidas, pero hay tres que destacan por su equilibrio entre facilidad, funciones y tasa de éxito: EaseUS Disk Copy, Wondershare UBackit y AOMEI Partition Assistant Professional. EaseUS Disk Copy EaseUS Disk Copy destaca por una interfaz clara y muy directa. Aunque Windows no traiga clonador nativo, con esta herramienta podrás replicar tu disco sin reinstalar nada. El flujo es sencillo: eliges modo de clonación (p. ej., Modo de disco), seleccionas el disco de origen, el destino y eliges cómo quieres distribuir las particiones en el nuevo NVMe. AOMEI Partition Assistant Professional AOMEI Partition Assistant Professional es más que un gestor de particiones; incluye un clonador de discos robusto que funciona muy bien entre unidades NVMe (y con otras combinaciones). Es compatible con distintas marcas (Samsung, Intel, WD y más) y permite migrar solo el sistema cuando no quieres copiar datos secundarios. Su asistente de clonación te deja escoger entre “Clonar el disco rápidamente” (copia solo el espacio usado, ideal para pasar a un NVMe más pequeño siempre que quepa) o “Clonar sector por sector” (copia todos los sectores, incluso los no usados). Al preparar el destino, suele convenir inicializar el nuevo NVMe como GPT para mantener la compatibilidad con UEFI. Un detalle útil en su flujo es la opción “Optimizar el rendimiento para SSD”, pensada para que la alineación y ajustes propios de SSD queden aplicados. Si trabajas con Windows Server, existe una edición específica: AOMEI Partition Assistant Server para entornos profesionales. Guías paso a paso para clonar tu disco a NVMe Vamos con lo importante: cómo ejecutar la clonación con cada herramienta. Elige la que más se ajuste a tu escenario y nivel de comodidad. Clonar NVMe a NVMe con EaseUS Disk Copy Al finalizar, apaga el PC y retira el disco antiguo o ajusta el orden de arranque para que el sistema inicie desde el NVMe clonado. Si todo fue bien, verás tu Windows y tus programas tal cual, pero con el plus de rendimiento. Clonar SATA (HDD/SSD) a NVMe con Wondershare UBackit Si te basta con un uso puntual, la prueba

SSD NVMe a 70 °C sin jugar: causas, diagnóstico y soluciones efectivas

¿Qué hacer cuando la temperatura de tu SSD NVMe sube de 70 °C? Si tu SSD NVMe marca 70–72 °C sin estar jugando, no eres el único. En muchos equipos, el módulo M.2 queda muy cerca de la gráfica y recibe su calor residual incluso cuando no estás en plena carga, lo que puede elevar la temperatura de forma constante. Esto se ve con frecuencia en montajes donde el slot M.2 está por encima de una GPU potente, como una 3070, y con configuraciones comunes de ventilación (AIO arriba como extracción, entradas frontales y salida trasera). Antes de entrar en pánico, hay matices importantes: muchos SSD están diseñados para trabajar de forma segura entre 0 y 70 °C, y se protegen bajando rendimiento si lo necesitan. Aun así, como norma práctica conviene que un NVMe no pase mucho tiempo por encima de ~65 °C, sobre todo si no hay actividad intensa. Además, la memoria NAND prefiere estar templada, pero no excesivamente caliente, así que buscaremos el equilibrio: buena ventilación y, si hace falta, disipación específica en la unidad. ¿Es normal ver 70–72 °C sin jugar? Puede suceder en equipos donde la GPU, incluso en reposo relativo, irradia calor al área del M.2. Si tu placa sitúa el NVMe justo encima o debajo de la gráfica, el calor ascendente o el aire caliente del radiador puede hacer que el SSD no baje de esa franja. También influye la temperatura ambiente, el diseño de la caja y cómo está organizado el flujo de aire. Se han reportado casos reales con Samsung 970 Evo/970 Evo Plus donde, con la gráfica cerca y sin un disipador específico en el M.2, las temperaturas se estabilizan altas al jugar y se quedan elevadas más tiempo al salir del juego. En otros montajes, con disipador dedicado en el M.2 y buena ventilación, es habitual ver el NVMe a 30–40 °C con ambiente de ~26 °C, lo que demuestra la influencia directa del enfriamiento y la ubicación física del módulo. En portátiles es distinto: el espacio es mínimo y no suele haber margen para disipadores en el M.2. Por eso es típico ver 50–65 °C en un NVMe de portátil en uso normal. No es necesariamente alarmante si no hay thermal throttling y la carga es sostenida, pero conviene verificar que el sistema disipa bien. En definitiva: 70–72 °C sin jugar no es ideal, pero tampoco implica desastre inmediato. Hay margen de maniobra y varias acciones que minimizan esa temperatura de forma efectiva, empezando por revisar la ventilación y el posicionamiento del NVMe respecto a la GPU. Cómo medir bien la temperatura del SSD Lo primero es monitorizar con herramientas fiables. Programas como HWMonitor u OpenHardwareMonitor ofrecen lectura de sensores de múltiples componentes, y suites más completas como AIDA64 muestran carga, temperatura y frecuencias de forma muy clara. Para CPU y GPU puedes añadir CoreTemp, CPU-Z y GPU-Z y tener una foto térmica del equipo al completo. Los componentes modernos integran sensores digitales que activan mecanismos automáticos cuando se superan ciertos umbrales. Esto incluye el aumento de velocidad de ventiladores, el recorte de consumo o el thermal throttling para proteger el hardware. En SSD NVMe, la protección suele activarse cuando la controladora alcanza temperaturas altas, reduciendo el rendimiento de lectura/escritura para mantener la seguridad. Consejo práctico: monitoriza durante varios minutos en reposo y bajo una actividad ligera (navegar, música, ofimática) para ver si la unidad cae por debajo de ~55–60 °C. Si se mantiene cerca de 70 °C sin procesos exigentes, el flujo de aire o la cercanía a la GPU probablemente están jugando en tu contra. Rangos y umbrales recomendables Como referencia general, muchos SSD se especifican para 0–70 °C. A nivel práctico, conviene mantener un NVMe por debajo de ~65 °C en uso prolongado, dejando margen antes de que la controladora limite rendimiento. Otros componentes también tienen sus zonas cómodas: CPU en torno a 80 °C (máximo recomendable), GPU ~85 °C, discos duros mecánicos ~50 °C y RAM ~50 °C. Importa recordar que la memoria NAND funciona bien estando templada, pero excesos sostenidos no son deseables. En algunos entornos de centros de datos se ha observado que las NAND pueden rendir mejor con cierta temperatura frente a frío extremo, pero eso no implica que debamos tener un NVMe al límite en un PC doméstico. Nuestro objetivo es estabilidad, vida útil y ausencia de thermal throttling. Diagnóstico rápido: paso a paso Antes de comprar nada, merece la pena un repaso ordenado. La idea es eliminar cuellos de botella obvios y confirmar que no haya fallos de base. Empieza por lo sencillo y ve avanzando: Mejoras de ventilación y colocación que sí marcan diferencia Una caja bien pensada hace milagros. Asegúrate de que entra aire fresco por el frontal, se expulsa por la parte superior y trasera, y que no creas bolsas de aire caliente. Mantén limpias las rejillas y filtros para evitar tapones de polvo. Evita quitar la tapa lateral de forma permanente: romperás el flujo de aire y normalmente terminarás con temperaturas más altas. La tapa también actúa como barrera frente a suciedad y mejora el canal de aire. Gestiona el cableado; un interior despejado facilita que el aire pase. Si vas a cambiar fuente, una modular ayuda a no acumular cables innecesarios y mejora mucho la limpieza del interior. Si tu AIO está delante, valora moverla arriba y poner ventiladores frontales de calidad metiendo aire. A veces, con solo revisar orientaciones y posiciones, bajas varios grados a todo el sistema, incluido el NVMe. Disipadores para M.2: cuándo usarlos y qué escoger Si tras optimizar el flujo de aire tu NVMe sigue alto, añade un disipador. Los integrados en muchas placas ayudan, pero los aftermarket suelen rendir mejor. Marcas como Sabrent y EK Water Blocks tienen opciones muy solventes; también hay modelos de One enjoy asequibles que cumplen. Algunos disipadores incluyen pequeños ventiladores de 20 mm. Pueden ser útiles en cajas con poco flujo, aunque generan algo de ruido. En tornillería y pads térmicos, sigue las instrucciones y evita apretar en exceso: busca buen contacto con la controladora y chips sin deformar la placa del M.2. No hay soluciones de refrigeración líquida dedicadas a SSD

Que significa PC3 12800s?

¿Qué significa PC3 12800s? Memoria Kingston La memoria DDR3-1600 tiene una clasificación del módulo para PC3-12800, lo que efectivamente significa que la velocidad de transmisión de datos pico del módulo es de 12,8GB/seg (ver tabla). Esto representa casi el 17% de mejora para el ancho de banda de la memoria en relación a la DDR3-1333. ¿Qué es PC3 10700? eso de «10600», «10666» y «10700» representa el pico maximo del ancho de banda y bueno siendo que se tienen 8bits por Byte, esos numeros surgen de esta multiplicacion: 1333×8=10664 (1600×8= 12800 o PC3-12800 para las 1600mhz), pero al final depende de cada fabricante la forma en que representa/nombra a la DDR3 1333mhz … ¿Qué son las memorias DDR3? – Definición de memoria DDR3 / DDR3 memory / dual data rate memory 3/ SDRAM DDR3: tecnología de almacenamiento electrónico aleatorio lanzada comercialmente en 2008, la cuál se conforma por una tarjeta plástica rectangular con medidas típicas de 133.35 mm X 31.75 mm X 1 mm., 240 terminales distribuidas en ambos lados … ¿Qué significa las letras de la memoria RAM? La memoria RAM (random access memory) o memoria de acceso aleatorio es un tipo de memoria volátil que permite almacenar datos e instrucciones de forma temporal mientras que el sistema hace uso de ella. Una vez dejan de usarse, esos datos desaparecen. ¿Qué es la frecuencia de las memorias RAM? Frecuencia de la RAM (MHz) La frecuencia de la RAM funciona a partir de los ciclos de reloj. Cada lectura y escritura se realiza en un ciclo. La RAM se mide por el número de ciclos por segundo que puede realizar. Por ejemplo, si la RAM está clasificada a 3200 MHz, realiza 3.200 millones de ciclos por segundo. ¿Cómo saber cuál es la frecuencia de una memoria RAM? Sus frecuencias fluctúan entre 800 MHz (el estándar PC4-12800), 933 MHz (el estándar PC4-14900), 1066 MHz (el estándar PC4-17000), 1200 MHz (el estándar PC4-19200), 1333 MHz (el estándar PC4-21300), y 1600 MHz (el estándar PC4-25600). ¿Cómo interpretar los datos de una memoria RAM? El segundo método es pulsar a la vez Control + Shift + Esc. Entrarás en el Administrador de tareas, donde tienes que ir a la pestaña Rendimiento y pulsar en Memoria. Verás la cantidad de memoria RAM que tienes, y también otra información útil como su velocidad, cuántas ranuras tiene y el factor de forma. Tasa de transferencia máxima de la memoria RAM Las memorias RAM son componentes electrónicos que ejecutan comandos al ritmo de un reloj cuya frecuencia es del orden del GHz. La tasa de transferencia máxima de las memorias RAM depende de esta frecuencia y del número de comandos ejecutados en cada ciclo de reloj. Las memorias DDR actuales permiten realizar dos comandos o transferencias de datos en cada ciclo. De hecho, el acrónimo DDR significa “Double Data Rate” en inglés, es decir “doble tasa de transferencia de datos”. Por ejemplo, si la frecuencia de la memoria DDR es 1600 MHz, puede realizar 2 × 1600 = 3200 millones de transferencias por segundo. Esta tasa de transferencia se expresa en MT/s (millones de transferencias por segundo) y aparece generalmente en las especificaciones de las memorias RAM. Se confunde a menudo con la frecuencia real de la memoria expresada en MHz. Por ejemplo, un módulo de memoria DDR4-3200 puede realizar 3200 millones de transferencias por segundo (3200 MT/s) y su frecuencia es 1600 MHz. Las memorias DDR4 utilizan un bus de 8 bytes (64 bits) para la transferencia de datos, por lo que su velocidad máxima en bytes por segundo será igual a ocho veces el número de transferencias por segundo. Por lo tanto, la velocidad máxima de un módulo de memoria DDR4-3200 será de 8 × 3200 millones de bytes por segundo, o 25600 MBytes/s. Esta información se encuentra a menudo en los nombres de los módulos de memoria RAM, así por ejemplo un módulo de memoria DDR4-3200 se llama a veces también PC4-25600. Los nombres utilizados por la industria redondean a veces la velocidad máxima para simplificar; así, el número de transferencias por segundo de la memoria RAM DDR4-2933 es 2933 MT/s, pero en su nombre su velocidad máxima se redondea a 23400 MB/s (en lugar de 23466,66 MB/s). La tabla siguiente contiene la velocidad, la tasa de transferencia de datos, la frecuencia y el nombre de los módulos de memoria más comunes. Frecuencia Tasa de Transferencia Velocidad Nombre 1066.66 MHz 2133.33 MT/s 17067 MB/s DDR4-2133 / PC4-17000 1200.00 MHz 2400.00 MT/s 19200 MB/s DDR4-2400 / PC4-19200 1333.33 MHz 2666.67 MT/s 21333 MB/s DDR4-2666 / PC4-21300 1466.67 MHz 2933.33 MT/s 23467 MB/s DDR4-2933 / PC4-23400 1500.00 MHz 3000.00 MT/s 24000 MB/s DDR4-3000 / PC4-24000 1600.00 MHz 3200.00 MT/s 25600 MB/s DDR4-3200 / PC4-25600 1733.33 MHz 3466.67 MT/s 27733 MB/s DDR4-3466 / PC4-27700 1800.00 MHz 3600.00 MT/s 28800 MB/s DDR4-3600 / PC4-28800 2000.00 MHz 4000.00 MT/s 32000 MB/s DDR4-4000 / PC4-32000 2066.67 MHz 4133.33 MT/s 33067 MB/s DDR4-4133 / PC4-33000 2133.33 MHz 4266.67 MT/s 34133 MB/s DDR4-4266 / PC4-34100 2200.00 MHz 4400.00 MT/s 35200 MB/s DDR4-4400 / PC4-35200 2250.00 MHz 4500.00 MT/s 36000 MB/s DDR4-4500 / PC4-36000 2300.00 MHz 4600.00 MT/s 36800 MB/s DDR4-4600 / PC4-36800 2400.00 MHz 4800.00 MT/s 38400 MB/s DDR4-4800 / PC4-38400 2550.00 MHz 5100.00 MT/s 40800 MB/s DDR4-5100 / PC4-40800 Como regla general, cuanto mayor sea su velocidad máxima, más rápida será la memoria y mayor será su precio. Tenga en cuenta que las velocidades más rápidas no son siempre compatibles con todos los microprocesadores. Es importante consultar las especificaciones técnicas de la CPU y de la placa base para verificar cuál es la velocidad de memoria máxima admitida antes de comprar una memoria ultra-rápida. Algunos pares de microprocesador / placa base admiten a veces velocidades más altas que las documentadas, los foros que tratan del overclocking de estos componentes le proporcionarán más información sobre este tema. Arquitectura interna de las memorias DDR4 Antes de ver unas características adicionales, es importante entender la arquitectura interna de las memorias DDR4. Cada bit de información de la memoria se almacena

SK hynix Chips DDR5 «A-Die» de 3 GB de segunda generación detectados, clasificados para 7200 MT / s

Una nueva generación de chips de memoria SK hynix DDR5 ha aparecido en línea, lo que marca el debut de los circuitos integrados de matriz A de 3 GB de segunda generación. Mostrado por primera vez por Kevin Wu de Team Group en Facebook, el chip lleva la marca X021 y el código de pieza «AKBD». Según el filtrador @unikoshardware, la etiqueta X021 lo identifica como el sucesor del chip M de 3 GB utilizado en los primeros módulos DDR5. Basado en el esquema de binning interno de SK hynix, la designación «KB» en AKBD probablemente corresponde a una velocidad JEDEC nativa de 7200 MT/s siguiendo la progresión establecida por la compañía desde «EB» (4800 MT/s) hasta «HB» (6400 MT/s). Este nuevo contenedor sugiere que SK hynix está preparando circuitos integrados DDR5 más rápidos dirigidos a las plataformas Intel de próxima generación, y se espera que Panther Lake y Arrow Lake Refresh admitan hasta DDR5-7200. Según los informes, la muestra que se muestra utiliza una PCB de 8 capas, lo que podría limitar el margen para un overclocking extremo más allá de 8000 MT / s. Para aprovechar al máximo el potencial del nuevo A-die, se espera que los fabricantes pasen a PCB de 10 o 12 capas para una mayor integridad de la señal. Si bien SK hynix aún no ha presentado oficialmente la pieza, esta aparición temprana del AKBD de 3 GB A-die insinúa que la producción ya puede estar en marcha. Para agregar algo de contexto, Samsung reinaba en los días de DDR4 con módulos de memoria de gama alta que casi siempre tenían los chips B-die seleccionados a mano por Samsung. Sin embargo, las cosas han cambiado en el mundo de la DDR5 con SK hynix tomando la delantera con sus chips A-die y M-die acaparando toda la atención.

JEDEC UFS 5.0: el salto a 10,8 GB/s en almacenamiento móvil

La organización JEDEC ha presentado oficialmente el nuevo estándar UFS 5.0, diseñado para ofrecer velocidades de transferencia secuenciales de hasta 10,8 GB/s. JEDEC UFS 5.0: el nuevo estándar que alcanza hasta 10,8 GB/s Este salto representa una mejora significativa respecto a la generación anterior y marca un paso clave en el desarrollo del almacenamiento de alto rendimiento para dispositivos móviles, automotrices y de computación avanzada que suelen usar este tipo de almacenamiento. UFS 5.0 introduce mejoras sustanciales en la arquitectura del sistema, con una mayor eficiencia energética y una reducción notable en la latencia. Uno de los avances más importantes es la incorporación de la ecualización de enlace, una tecnología que mejora la integridad de la señal, permitiendo mantener altas velocidades incluso en trayectos más largos o bajo condiciones de interferencia eléctrica. Estas innovaciones buscan responder a las crecientes demandas de los dispositivos modernos, especialmente aquellos que dependen de tareas intensivas en datos como la inteligencia artificial, la realidad aumentada y las aplicaciones de computación en el borde. Gracias a estas mejoras, los futuros smartphones, consolas portátiles y sistemas integrados podrán acceder a velocidades que antes eran exclusivas de soluciones SSD de equipos de sobremesa. Comparado con UFS 4.0, que ya ofrecía un gran rendimiento, el nuevo estándar prácticamente duplica la velocidad teórica de transferencia, abriendo el camino a una nueva generación de almacenamiento embebido de alta velocidad. Aunque su adopción tomará tiempo debido a la necesidad de nuevos controladores y componentes compatibles, UFS 5.0 representa un avance clave en la evolución del almacenamiento en este segmento. Os mantendremos al tanto de todas las novedades.

Esta configuración de Windows 11 (que seguramente tienes activa) está restando años de vida a tu disco SSD

Dejar Windows 11 con la configuración por defecto es perjudicial para el disco duro. El SSD está en constante peligro si usas inadecuadamente la memoria virtual. No hay que saber mucho de ordenadores para entender que el disco duro es uno de los componentes más importantes, pues aquí es donde se almacenan todas las aplicaciones, archivos y el sistema operativo. Con el tiempo, su vida útil se va reduciendo hasta volverse lento, presentar errores o generar pérdida de datos, cosa que no quieres que te pase, al menos no dentro de unos 5 años. Mantener la longevidad de este tipo de piezas es crucial para que tengas una buena experiencia y que no haya inconvenientes con el rendimiento. Si tienes Windows 11, lo más probable es que tengas una configuración predeterminada que podría desgastar dicho componente con el uso a largo plazo. Lo hace principalmente cuando el dispositivo no cuenta con la RAM suficiente para la exigencia que se le pide, causando que tome “prestado” parte del disco duro para convertirlo en memoria virtual. Sí, el uso frecuente de esta característica podría estar deteriorando cada vez más rápido el SSD por tener una carga adicional, pero puedes intentar solucionarlo con algunos cambios. ¿Qué es y cómo funciona la memoria virtual? Si te pregunto cómo funciona la memoria virtual de Windows 11, es prácticamente una característica disponible en los SSD que permite que el equipo pueda hacer uso del parte del disco duro para que se utilice como memoria RAM adicional. Estos GB adicionales son virtuales y funcionan junto con la disponibilidad física, pero no cuentan con la misma potencia El proceso de conversión suele pasar cuando la memoria RAM de tu ordenador se queda sin espacio o está a punto de hacerlo. El sistema operativo adapta el disco duro para que algunos de los procesos que no son tan demandantes se han pasado al archivo de paginación con el fin de que se libere carga. De este modo, las aplicaciones que se mantienen activas y que son de “baja prioridad”, quedan con una mayor fluidez y como menos probabilidades de presentar inconvenientes de rendimiento, fallos de congelación u otros errores. En sí, hace que se reduce la exigencia sobre la memoria RAM, pero el problema es que ese mismo peso se va al disco duro y puede influir negativamente en él con respecto a su vida útil. Esto se debe que constantemente está moviendo datos y procesos de un lado a otro, haciendo que tenga un desgaste más prematuro que el que debería tener. Si sueles jugar a videojuegos AAA, ejecutar programas de renderizado o diseño, usar máquinas virtuales y realizar acciones que implican un consumo elevado, por muy avanzado y moderno que sea el SSD, va a impactar con su salud. No lo desactives: optimiza el archivo de paginación con este método La memoria virtual o archivo de paginación crea desventajas, pero eso no es suficiente para que decidas desactivar la función por completo. En sí, es un método de protección para el SSD, solo que en uso excesivo, causa un efecto contrario. Por lo tanto, la idea es que se configure de una manera que pueda servir de la forma más óptima posible. ¿Cómo se hace? Primero hay que reconocer que deshabilitar la memoria virtual es buena opción solo cuando tu PC cuenta con 16 GB de RAM o más. De lo contrario, lo mejor es ajustar el tamaño fijo y eso es posible hacerlo si buscas en el Menú de Inicio la herramienta de Configuración Avanzada del Sistema. Entra en Opciones Avanzadas y después nuevamente a Opciones Avanzadas para seleccionar en Cambiar Memoria Virtual. Desmarca la casilla de Administrar Automáticamente el Tamaño del Archivo de Paginación para Todas las Unidades y habilita la casilla de Tamaño Personalizado. Aquí tienes que poner el espacio en MB para después darle al botón de Aceptar. Esto evitará que el SSD esté siendo tan forzado, pues el objetivo es reducir la cantidad de memoria requerida o adaptarla de la mejor manera de acuerdo a tu RAM. Definitivamente, es una de esas cosas que se suelen pasar por alto, pero que podría convertirse en un gran problema.

OpenAI amarra memoria y centros en Corea con Samsung y SK Hynix

La capital surcoreana ha sido escenario de una ronda de encuentros en la que OpenAI, Samsung y SK Hynix han alineado intereses para su macroiniciativa de centros de datos, conocida como Stargate. En esos contactos, se plasmó por escrito un objetivo que destaca por su envergadura: producir hasta 900.000 obleas de DRAM al mes y reforzar la construcción de infraestructuras de IA en el país. Las partes describen el paquete como una combinación de acuerdos preliminares de suministro de memoria y evaluaciones para nuevos emplazamientos. El mensaje es claro: Corea del Sur aspira a consolidarse entre los líderes en inteligencia artificial, mientras que OpenAI busca asegurar capacidad industrial y energética para sus próximos modelos. Una meta de producción que puede tensar la cadena de memoria Las obleas son discos de silicio sobre los que se fabrican chips; de cada una se obtienen numerosos circuitos que terminan siendo módulos DRAM o pilas HBM de alto rendimiento para servidores y centros de datos. El listón fijado contrasta con el mercado actual. Estimaciones del sector sitúan la capacidad global de obleas DRAM de 300 mm en torno a 2,07 millones mensuales en 2024, con una subida hacia 2,25 millones en 2025. Alcanzar 900.000 equivaldría a cerca del 39% de toda esa capacidad, una escala que ningún fabricante individual cubre por sí mismo y que ilustra la ambición del plan. La diferencia entre inferencia y entrenamiento ayuda a entender la cifra. Para entrenar modelos de nueva generación se agrupan miles de aceleradores, cada uno acompañado de grandes cantidades de memoria rápida, además de sistemas de refrigeración y potencia eléctrica a gran escala. De ahí que asegurar suministro de obleas no parezca un exceso, sino un requisito para la siguiente oleada de modelos. Al mismo tiempo, desde la industria se apunta que la demanda vinculada a Stargate podría superar ampliamente la capacidad mundial actual de HBM, reforzando el liderazgo de los grandes productores y empujando a toda la cadena de valor a invertir. Memorandos, actores implicados y nuevos centros en Corea Los documentos firmados recogen compromisos iniciales para ampliar la producción de memoria y evaluar nueva infraestructura en Corea del Sur. En ese frente, Samsung SDS participaría en el desarrollo de centros de datos, mientras que Samsung C&T y Samsung Heavy Industries estudiarían diseño y construcción. El Ministerio de Ciencia y TIC valora ubicaciones fuera del área metropolitana de Seúl y SK Telecom ha acordado analizar un emplazamiento en el suroeste del país. En paralelo, ambas compañías sopesan integrar ChatGPT Enterprise y capacidades de API en sus operaciones para optimizar flujos de trabajo e impulsar la innovación interna. El proyecto Stargate se apoya en una alianza con SoftBank, Oracle y la firma de inversión MGX, que contempla destinar 500.000 millones de dólares hasta 2029 a infraestructura de IA, con el foco puesto en Estados Unidos y efectos colaterales en ecosistemas como el surcoreano. Conviene subrayar que se trata, por ahora, de cartas de intención y memorandos: la ambición es alta, pero faltan detalles clave por cerrar. Los riesgos no son menores: posibles cuellos de botella en HBM/DRAM, necesidades eléctricas de varios gigavatios, permisos y la coordinación de proyectos con múltiples actores. El músculo de cómputo y el giro estratégico de OpenAI OpenAI viene tejiendo alianzas para elevar su capacidad de cómputo. Con Oracle y SoftBank prepara varios centros de datos de gran escala que aportarían gigavatios de potencia, mientras que NVIDIA ha anunciado inversiones de hasta 100.000 millones de dólares y el acceso a más de 10 GW mediante sus sistemas de entrenamiento. La relación con Microsoft ha sido decisiva: los desembolsos iniciales de 1.000 millones y posteriores de 10.000 millones dieron acceso a Azure, clave para entrenar modelos que impulsaron el auge de ChatGPT. Ahora, OpenAI avanza hacia infraestructuras con mayor control directo para reducir dependencia de un único proveedor. El ecosistema surcoreano también explora fórmulas novedosas junto a OpenAI, desde colaboraciones de diseño hasta conceptos como centros de datos flotantes, con el objetivo de acelerar la implantación de infraestructuras resilientes y eficientes. El mercado reaccionó con alzas notables tras los anuncios: Samsung subió en torno al 4%-5% hasta máximos de varias anualidades, mientras que SK Hynix rebotó cerca del 10% y el índice KOSPI superó los 3.500 puntos por primera vez. En conjunto, los movimientos añadieron decenas de miles de millones a su capitalización. Analistas del sector consideran que el empuje de Stargate disiparía temores sobre una caída inminente de precios en memoria HBM y podría actuar como catalizador para proveedores de equipamiento como ASML, dada la elevada demanda ligada a chips de memoria avanzada. El panorama que se abre combina ambición industrial y prudencia operativa: los memorandos dibujan una hoja de ruta que, si se materializa, aseguraría a OpenAI un caudal de memoria y nuevas instalaciones en Corea del Sur, mientras Samsung y SK Hynix afianzarían su papel en la carrera global por la IA; todo ello pendiente de cómo evolucionen la capacidad de producción, la energía disponible y los ritmos regulatorios.

Memoria y almacenamiento, al límite: la ola de IA vacía el “granero” de DRAM, NAND, SSD y HDD y dispara los precios

La industria de la memoria vive una situación inédita: DRAM, NAND Flash, SSD y discos duros se han quedado simultáneamente en mínimos. Lo que durante meses se temió como un ciclo alcista sostenido ha desembocado en escasez generalizada que ya se nota en contratos y precios de contado, y que amenaza con trasladarse a lineales y presupuestos de hogares y pymes en las próximas semanas. La confirmación más contundente llega desde Adata, referente mundial en módulos de memoria. Su presidente, Simon Chen, resumió el momento con una imagen gráfica: el “granero” de los fabricantes está prácticamente vacío y los grandes proveedores de nube (CSP) —OpenAI, AWS, Google, Microsoft— han pasado a ser los competidores reales de los ensambladores y distribuidores tradicionales a la hora de asegurarse suministro. Nunca —dice— había visto en 30 años una escasez simultánea de las cuatro familias principales de memoria y almacenamiento. Qué está ocurriendo: cuatro mercados apretados a la vez El diagnóstico de Adata es claro: los CSP firman contratos masivos de servidores de IA por importes milmillonarios y arrastran consigo una demanda explosiva de HBM/DRAM y almacenamiento. El resto de clientes —PC, pymes, integradores locales, incluso parte del canal— reciben menos y más tarde. Cuándo se notará (y dónde) Aunque el consumidor aún puede encontrar producto en tienda, ese stock es el que ya estaba en los almacenes. Donde ya escasea es upstream: fabricantes (FAB) y distribuidores con inventarios reducidos a 2–3 semanas —cuando lo habitual eran 2–3 meses—. Adata habla de “vender con moderación y priorizar a los clientes clave”, a la espera de reposiciones. El traslado a precio está en marcha. Un kit DDR5 de 32 GB que a principios de año rondaba los 85 dólares supera ya los 120 en múltiples mercados. En el canal profesional, los contratos de DDR4/DDR5 apuntan a +20–30 % y el spot va por delante. En SSD la inercia es similar: si HDD se aprieta, NAND se recalienta. Por qué ahora: el “nuevo ciclo” de la memoria La memoria era, históricamente, un negocio de ciclos de 3–4 años: épocas de fuerte inversión, sobreoferta, bajada de precios, limpieza de inventarios y posterior recuperación. La IA ha cambiado las reglas. Según Adata, el alza se ha prolongado y desacoplado de ese patrón. El margen está en las líneas de valor (HBM para GPU, DDR5 densa para servidor), y ahí es donde se ancla la capacidad. No es solo una cuestión de capex: reabrir una línea de DDR4 no es trivial ni tiene sentido económico si la demanda más rentable está en otra parte. Esa es la asimetría: la base instalada fuera de hiperescala necesita componentes “anteriores”, pero el futuro del margen vive en HBM/DDR5 y NAND para cargas de IA. Consecuencias prácticas: del CPD a la pyme, pasando por el PC gaming El efecto dominó: cuando el HDD aprieta, el SSD se encarece La escasez en HDD —por prudencia de pedidos y inventarios depurados— impulsa a muchos clientes a acelerar migraciones a SSD, pero eso retroalimenta la tensión en NAND. Aunque varios fabricantes han anunciado expansiones de 15–30 %, la realidad industrial (equipos, sala blanca, ramp-up, rendimiento) hace que el alivio no llegue a corto plazo. Entre tanto, algunos compradores aseguran cupos trimestrales o anuales, lo que rigidiza aún más la disponibilidad para el canal abierto. El punto de no retorno para DDR4 El caso de DDR4 es paradigmático. Con líneas paradas o reducidas al mínimo, la oferta solo atenderá contratos heredados. Adata habla de escasez estructural y de “primar” clientes críticos. Para quienes mantienen infraestructuras o PC que dependen de DDR4, el mensaje es inequívoco: blindar ahora capacidad y repuestos puede evitar costes y paradas mayores dentro de unos meses. ¿Qué pueden hacer las empresas? 1) Auditoría de inventario y necesidades reales (90 días / 12 meses).Mapear consumos, plazos de renovación, picos estacionales y SLA internos. En CPD, evaluar consolidación de cargas y despliegues diferidos. 2) Estrategias de compra más largas.Donde sea posible, contratos a varios trimestres para asegurar cupo y precio. En pymes, trabajar con distribuidores que ofrezcan backorder y asignación. 3) Flexibilidad técnica.Explorar mix de capacidad/frecuencias en DRAM, perfiles RDIMM/LRDIMM según plataforma, y en almacenamiento combinar SSD TLC/QML con políticas de datos (tiering, cold storage en HDD cuando haya). 4) Eficiencia de software.Optimizar memoria en aplicaciones, compresión, paginación, deduplicación en hipervisores y gestión de cachés. La eficiencia puede liberar GB que hoy son oro. 5) Planes de contingencia.Para sistemas críticos, stock de seguridad y rotación de módulos; para oficinas, reutilización planificada (p. ej., mover DDR5 nueva a equipos clave y reciclar módulos a puestos menos críticos). Y los consumidores, ¿qué pueden hacer? Un mercado que ya no funciona como antes Para Adata, la nueva normalidad es que los CSP “no cancelan” y compiten con una escala cien veces mayor que los clientes tradicionales: así se prioriza capacidad y precio. La consecuencia es una reconfiguración del precio relativo de la memoria y el almacenamiento, con una fase alcista que se alarga más allá de lo habitual. En paralelo, el canal se vuelve más selectivo: “vender con moderación” y “apoyar a clientes principales” son instrucciones que revelan hasta qué punto la escasez se gestiona a mano. ¿Cuándo podría normalizarse? Aun con expansiones del 15–30 % en marcha, los tiempos de puesta en producción de nuevas líneas y los cambios de mix de producto hacen pensar en plazos largos: no habrá respiro inmediato. El ajuste dependerá de tres factores: Mientras tanto, el mercado retail resistirá con lo que hay en almacenes. Pero si la demanda de hiperescala no afloja, la tensión bajará por la cadena hasta las estanterías. Preguntas frecuentes ¿Por qué escasean a la vez DRAM, NAND, SSD y HDD?Porque la demanda de IA ha arrastrado capacidad hacia HBM y DDR5 de alto margen, dejando DDR4 en mínimos. La prudencia en pedidos de HDD empuja a muchos clientes a SSD, que a su vez tiran de NAND. Con inventarios bajos y plazos de expansión de >2,5 años, las cuatro familias quedan tensionadas a la vez. ¿Subirán más los precios de DDR4 y DDR5?Según Adata, los contratos DDR4/DDR5 ya reflejan +20–30 % entre finales de 2025 y primer semestre de 2026, con spot aún más alto. En DDR4 la escasez es estructural por la parada de líneas; en DDR5 el alza es más moderada, pero real. ¿Tiene sentido comprar ahora RAM o SSD?Si hay necesidad real (equipo de trabajo, servidor, ampliación urgente), sí: el riesgo de más subidas y falta puntual de stock es alto. Si es una compra discrecional, conviene comparar y valorar el cambio de plataforma para no invertir en componentes con oferta menguante (caso de DDR4). ¿Cuándo se normalizará el suministro?Aunque hay planes de +15–30 % de capacidad, el ramp-up industrial tarda más de 2,5 años. La normalización dependerá de cómo evolucione la demanda de centros de datos de IA y de la priorización de los fabricantes entre HBM/DDR5 y el resto de líneas. A corto plazo, no se espera alivio significativo.

El CEO de Phison dice que la escasez de memoria podría durar 10 años, gracias a la ‘IA’

La alta demanda de centros de datos industriales, con mucha memoria y almacenamiento de estado sólido, podría crear una crisis masiva que eleve los precios de prácticamente todos los productos electrónicos. Entre los centros de datos que brotan como margaritas y la memoria DDR4 que antes era asequible y que finalmente se desvanece en el ocaso, estamos viendo tiempos difíciles para los precios de la memoria y el almacenamiento, y eso es antes de que la agitación económica general y los aranceles compliquen aún más las cosas. Ahora, el CEO de un importante productor de hardware flash incluso advierte que podríamos estar viendo una escasez de una década. Dicho CEO es Pua Khein-Seng de Phison Electronics. Phison no tiene mucha visibilidad en el espacio del consumidor, pero es uno de los mayores fabricantes de controladores de memoria NAND del planeta. (Es muy probable que haya chips Phison en el dispositivo que está usando para leer estas palabras). En una entrevista con Tech Taiwan, Pua predijo que tendremos una escasez total de memoria el próximo año, con centros de datos hechos para aumentar la capacidad en general y productos de «IA» en particular creando una escasez de hardware en toda la industria. Eso es especialmente cierto a medida que los grandes centros de datos pasan de los discos duros convencionales (el último gran reducto para la tecnología de décadas de antigüedad) a las unidades de estado sólido. Eso inevitablemente elevaría el precio de la memoria y el almacenamiento basados en flash y, por extensión, aumentaría los precios de más o menos todos los productos electrónicos de consumo, incluidos teléfonos, PC y tarjetas gráficas. Incluso los dispositivos con electrónica integrada en su mayoría «invisibles», como monitores o auriculares, se verían afectados. Con una reducción de la inversión después de la pandemia, seguida inmediatamente por una creciente demanda de la burbuja de IA, Pua estima que podríamos ver una escasez que dure hasta una década, según TechPowerUp. Debo señalar que el CEO de un importante proveedor de controladores de memoria no es exactamente una fuente imparcial de información sobre el asunto. Phison podría estar tratando de estimular la inversión o dar cuenta de algunos tiempos difíciles en su propio futuro. Pero hablando como alguien que definitivamente está en el lado del consumidor de esta ecuación, no veo nada que esté obviamente mal en una predicción de escasez. La mayoría de los demás analistas ya predicen precios más altos a corto plazo, y ciertamente es posible que la escasez se mantenga durante varios años.

¿Comprar un PC nuevo? Puede que tengas que ponerle tú mismo la memoria RAM

Conforme avanzan los meses los problemas que vemos relacionados con la memoria se vuelven más graves. Los principales analistas del sector indican que no veremos pronto el cese de la escasez, mientras que grandes marcas de la industria tampoco tienen claro cuándo terminará. Y a esto ahora hay que sumar un nuevo movimiento por parte de los fabricantes, dar la opción a comprar un PC… sin memoria. Los ordenadores barebone llevan mucho tiempo siendo un modelo específico que está diseñado para usuarios que quieren incorporar su propia RAM. Este tipo de sistemas suelen llegar completamente integrados a falta de dos componentes clave, la RAM y el almacenamiento. Principalmente encontramos este tipo de sistemas en aquellos que tienen un formato de mini-PC para que el comprador pueda instalar la memoria y capacidad que necesita. Pero los últimos movimientos del sector dejan claro que esto podría convertirse en algo que terminaríamos viendo en otro tipo de ordenadores. Algunos integradores de sistemas están comenzando a distribuir sus dispositivos con esta configuración. Esto les permitiría continuar vendiendo el producto por el precio base, pero al final el usuario tendría que continuar pagando los precios actuales de la RAM. La solución que proponen algunos fabricantes para hacer frente a la escasez, vender PC sin RAM A la hora de configurar un PC existen muchas formas de encontrar los componentes ideales. Hay quienes prefieren montarlo ellos mismos a base de comprar las piezas, otras personas buscan un modelo que ya esté montado. Y también están quienes buscan algo que ya esté integrado, pero que permita cierta personalización como es a nivel de memoria y almacenamiento. Como bien hemos comentado estos serían los ordenadores de tipo barebone, una de las últimas soluciones que los integradores de sistemas podrían utilizar para hacer frente a la crisis de memoria. En los últimos días marcas como MAINGEAR, una compañía estadounidense que se dedica a fabricar ordenadores de alta gama, han anunciado nuevos modelos de PC que se basan en esta premisa. Estos ordenadores tienen una gran peculiaridad y es que no es el usuario quien debe montar la RAM una vez lo recibe. En este caso el usuario debe mandar sus módulos de memoria a la marca para que desde sus instalaciones gestionen la instalación completa. Esto resulta bastante peculiar ya que la propia compañía se encarga de pagar el envío entre otras cosas, además de hacer todas las pruebas necesarias para saber que funciona correctamente. Otros ensambladores de este tipo han decidido parar directamente los pedidos de productos hasta que la situación se estabilice. La propuesta que tiene MAINGEAR resulta realmente original ya que permite a los usuarios reutilizar una parte de sus antiguos ordenadores. Sobre todo en términos de memoria DDR5. Aunque no es una solución a largo plazo ya que al final en caso de dar el salto de DDR4 a DDR5 es necesario pagar igualmente por el módulo completo